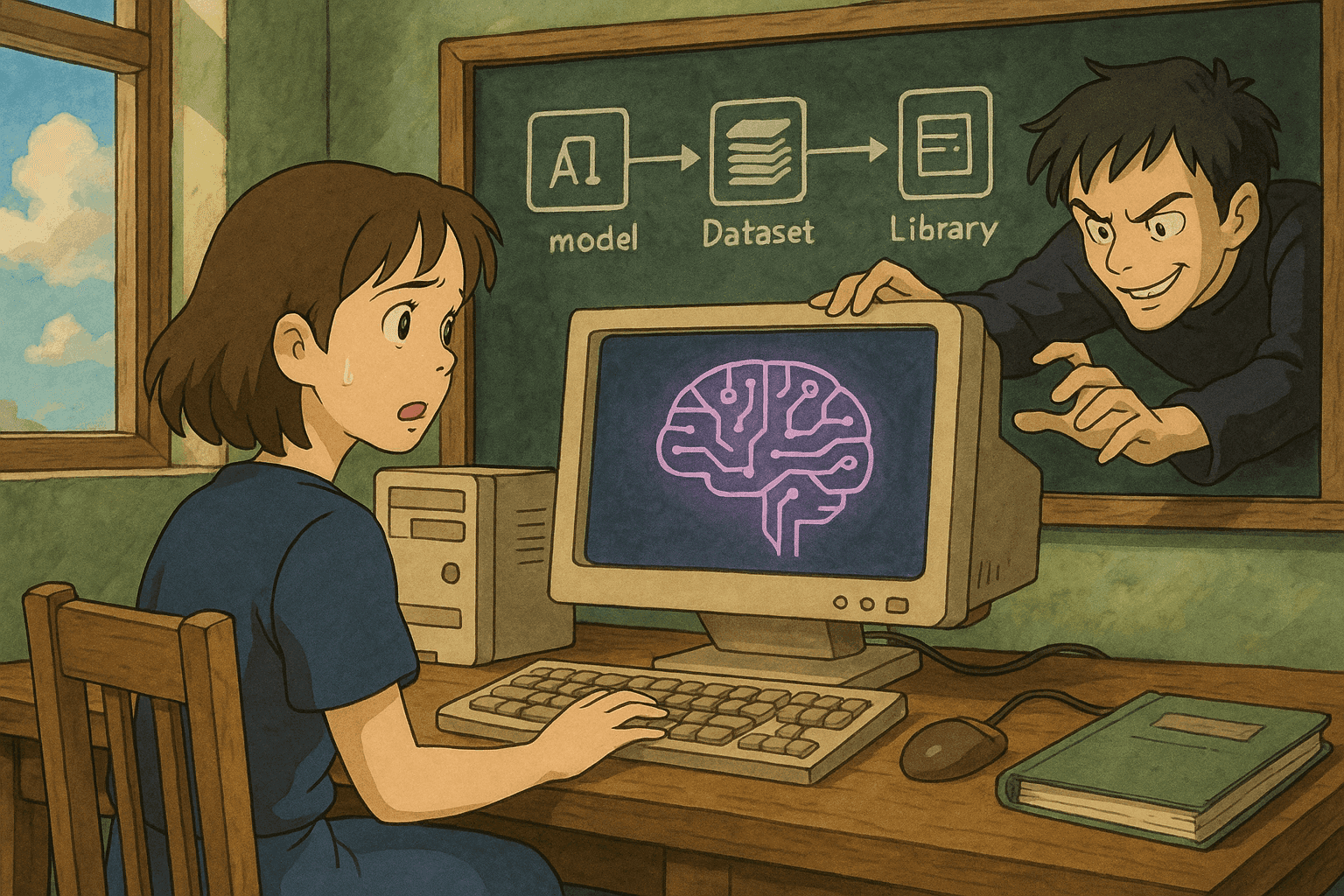

供应链攻击对人工智能的威胁

人工智能中的供应链威胁,如被投毒的模型、受污染的数据集和恶意库,可能破坏机器学习应用的完整性。本文探讨攻击者如何渗透管道、规避检测及利用AI开发过程中的信任。

# 滥用 AI 供应链:被投毒的模型、数据与第三方库如何危害 AI 系统

*作者: [Your Name]*

*日期: 2025 年 8 月 18 日*

人工智能(AI)正在迅速改变各行各业。然而,与所有创新一样,AI 系统并非没有漏洞。近年来,针对 AI 产物(包括被投毒的模型、被篡改的数据以及被植入恶意代码的第三方库)的供应链攻击已成为一项重大威胁。本文将探讨攻击者如何通过供应链危害 AI 系统,解释常见攻击向量,给出真实案例,并提供使用 Bash 与 Python 扫描、解析漏洞的代码示例。

---

## 目录

1. [引言](#引言)

2. [了解 AI 供应链](#了解-ai-供应链)

3. [AI 供应链的常见攻击向量](#ai-供应链的常见攻击向量)

- [模型投毒](#模型投毒)

- [数据管道被攻陷](#数据管道被攻陷)

- [第三方库利用](#第三方库利用)

4. [真实案例](#真实案例)

5. [扫描与解析漏洞的代码示例](#扫描与解析漏洞的代码示例)

- [Bash 示例:扫描易受攻击的依赖](#bash-示例)

- [Python 示例:解析扫描结果](#python-示例)

6. [保护 AI 供应链的最佳实践](#最佳实践)

7. [结论](#结论)

8. [参考文献](#参考文献)

---

## 引言<a name="引言"></a>

现代 AI 系统依赖庞大的供应链:预训练模型、数据集、以及数量可观的第三方库。这些组件加速了开发与部署,但也给攻击者提供了切入口。只要供应链中的任意环节被篡改,攻击者就能注入恶意数据、改变模型行为,或植入隐蔽的漏洞,直至在生产环境中被利用。

本文围绕“滥用供应链:被投毒的模型、数据与第三方库如何危害 AI 系统”展开,详述攻击者如何获得初始权限、如何规避检测,以及如何利用凭证或资源进一步渗透 AI 基础设施。本指南面向数据科学家、安全工程师与 DevOps 专业人士,帮助大家保护 AI 流水线。

---

## 了解 AI 供应链<a name="了解-ai-供应链"></a>

AI 供应链涵盖所有内部与外部组件,这些组件共同参与模型的开发、训练、部署与运行。主要包括:

- **预训练模型与检查点**:通常来自公共仓库或第三方供应商。

- **数据集**:用于训练或微调模型,可能是自行收集、人工整理或采购所得。

- **第三方库**:开源框架、工具包与实用脚本,用于构建 AI 流水线。

- **部署工具**:云资源、API 与 CI/CD 流水线,用于将 AI 投入生产。

每个组件都是潜在的风险点,一旦被攻破,危害将沿供应链向下游传播,影响整体 AI 系统。

---

## AI 供应链的常见攻击向量<a name="ai-供应链的常见攻击向量"></a>

我们将关键攻击向量分类并深入说明。

### 模型投毒<a name="模型投毒"></a>

**定义:** 当攻击者故意在训练数据或模型权重中注入恶意模式,导致模型产生异常行为,即为模型投毒。极端情况下,被投毒的模型会完全误分类、泄露敏感信息,甚至造成经济损失。

**攻击场景:**

1. 一个广泛使用的预训练模型托管于开源仓库。

2. 攻击者提交 PR,暗中修改训练脚本或权重。

3. 中毒模型被部署后,对关键输入产生误判(例如让反欺诈系统忽视真实欺诈)。

**影响:**

- 模型性能下降

- 预测结果不准确

- 对第三方模型的信任度下降

### 数据管道被攻陷<a name="数据管道被攻陷"></a>

**定义:** 数据投毒是指在训练数据进入模型之前,攻击者刻意篡改数据,使模型学习到错误关联或偏见。这类异常通常难以通过统计方法检测。

**攻击场景:**

1. 攻击者获得数据存储或采集管道的写权限。

2. 向数据集中注入恶意样本,模型将这些样本当作合法信号学习。

3. 在生产推理阶段,模型输出被操纵,做出错误安全决策或医疗诊断。

**影响:**

- 预测准确率降低

- 模型偏见增大

- 推理阶段更易被对手利用

### 第三方库利用<a name="第三方库利用"></a>

**定义:** 当攻击者在开源库中植入恶意代码或漏洞时,即发生第三方库利用。AI 项目常依赖数百个库,一旦其中一个被攻陷,整体应用就可能被攻陷。

**攻击场景:**

1. 恶意开发者通过拼写欺骗(typosquatting)或依赖混淆发布含后门的 Python 包。

2. 项目在更新或安装依赖时执行恶意代码。

3. 攻击者借此创建后门、窃取数据或提升权限。

**影响:**

- 大规模供应链攻击

- 生产环境持久化后门

- 修改细微,检测难度大

---

## 真实案例<a name="真实案例"></a>

以下高危事件证明了 AI 供应链风险并非纸上谈兵。

### 案例 1:开源模型仓库被篡改

某热门模型仓库曾被攻击者提交含隐蔽逻辑的 PR,宣称能“优化性能”,实际上在特定条件下强制误分类。此版本在多家企业被部署,直到终端用户报告异常才被发现,最终导致产品召回与信誉损失。

### 案例 2:金融服务中的数据投毒

一家大型金融机构的内部数据管道遭到渗透,攻击者持续注入篡改交易记录,导致反欺诈模型逐渐忽视真实欺诈行为。公司蒙受巨额损失后,才意识到数据管道缺乏严密防护。

### 案例 3:第三方库漏洞利用

某流行数据处理库发布的恶意更新含远程代码执行后门,通过公共包索引分发,全球数十个 AI 应用受影响。该事件直至跨项目监控与快速响应才得以遏制。

---

## 扫描与解析漏洞的代码示例<a name="扫描与解析漏洞的代码示例"></a>

以下示例帮助你主动防御供应链攻击。

### Bash 示例:扫描易受攻击的依赖<a name="bash-示例"></a>

使用开源工具 Safety(Python 依赖漏洞扫描器)检测依赖漏洞。首先执行 `pip install safety` 安装。

```bash

#!/bin/bash

# scan_packages.sh: 扫描 Python 项目的依赖漏洞

REQUIREMENTS_FILE="requirements.txt"

if [ ! -f "$REQUIREMENTS_FILE" ]; then

echo "错误: 未找到 $REQUIREMENTS_FILE!"

exit 1

fi

echo "正在扫描依赖漏洞..."

safety check -r "$REQUIREMENTS_FILE" --full-report

if [ $? -ne 0 ]; then

echo "检测到漏洞,请审查上述报告。"

exit 1

else

echo "未发现已知依赖漏洞!"

fi

用法:

- 保存为

scan_packages.sh - 赋予执行权限:

chmod +x scan_packages.sh - 运行:

./scan_packages.sh

将此脚本集成到 CI/CD,即可在部署前自动扫描第三方库。

Python 示例:解析扫描结果

如需对扫描结果进行程序化分析,可使用下列脚本解析 JSON 输出并生成摘要。

#!/usr/bin/env python3

"""

parse_vulnerabilities.py: 解析漏洞扫描输出。

假设输入为漏洞扫描器生成的 JSON 文件。

"""

import json

import sys

def parse_vulnerabilities(output_file):

try:

with open(output_file, 'r') as file:

vulnerabilities = json.load(file)

except Exception as e:

print(f"读取 {output_file} 出错: {e}")

sys.exit(1)

if not vulnerabilities.get("vulnerabilities"):

print("扫描结果未发现漏洞!")

return

for vul in vulnerabilities["vulnerabilities"]:

package = vul.get("package", "Unknown")

version = vul.get("version", "Unknown")

advisory = vul.get("advisory", "No advisory provided")

severity = vul.get("severity", "Unknown").upper()

print(f"Package: {package}")

print(f"Version: {version}")

print(f"Severity: {severity}")

print(f"Advisory: {advisory}")

print("-" * 40)

if __name__ == "__main__":

if len(sys.argv) != 2:

print("用法: python3 parse_vulnerabilities.py <output_file.json>")

sys.exit(1)

parse_vulnerabilities(sys.argv[1])

用法:

- 保存为

parse_vulnerabilities.py - 准备好扫描器生成的 JSON 输出

- 运行:

python3 parse_vulnerabilities.py scan_output.json

可将结果集成到仪表盘或告警系统,及时发现风险。

保护 AI 供应链的最佳实践

要防范供应链攻击,需要多层防护。以下策略值得采纳:

1. 保护数据管道

- 身份验证与访问控制: 限制写入权限。

- 数据校验: 部署严格的校验与异常检测。

- 审计与监控: 持续监控数据变动。

2. 校验第三方组件

- 依赖管理: 使用 Dependabot、Snyk、Safety 等工具自动扫描与更新。

- 供应链安全: 仅从可信仓库获取库,考虑启用签名校验。

- 隔离与容器化: 在隔离环境运行第三方代码。

3. 监控与审计模型

- 模型完整性验证: 通过哈希或数字签名确保部署版本可靠。

- 行为监控: 在推理阶段监控输出异常。

- 可解释性工具: 引入可解释性检测模型决策流程。

4. 自动化 CI/CD 安全

- 集成安全工具: 静态分析、依赖与镜像扫描。

- 及时更新补丁: 快速修补所有软件组件。

- 事件响应计划: 针对 AI 平台重新制定检测、响应与恢复流程。

5. 团队培训

- 安全意识: 全员了解供应链风险。

- 代码审查与审计: 定期审查内部代码与第三方代码。

- 跨职能协作: 促进数据科学、DevOps 与安全团队协作。

结论

随着 AI 系统深度融入业务流程,攻击者也在不断创新,瞄准供应链每一环节:模型投毒、数据篡改、第三方库后门。若无前瞻性防御,这些高阶攻击将严重破坏信任与安全。

保护 AI 供应链需主动出击:结合严格审计、持续监控及自动化安全工具。在这方面,诸如 Datadog 等可观测性平台能实时发现异常与威胁。

本文深入解析了攻击手法、真实案例与可落地的代码示例,帮助你把安全实践融入日常开发。只要保持信息更新、持续优化安全 posture,即可显著降低供应链攻击风险,为 AI 系统构筑可信边界。

参考文献

- Datadog:可观测与安全平台

- Gartner《可观测性平台魔力象限》

- Safety – Python 依赖漏洞扫描

- OWASP 软件组件验证标准 (SCVS)

- Dependabot – 自动依赖更新

- Snyk – 开源依赖安全

随着瞄准 AI 系统的供应链攻击愈发复杂,请保持警惕,不断提升安全防御能力。落实本文策略与实践,助你抵御模型投毒、数据篡改及第三方库后门等威胁。

安全永无止境,愿大家编码顺利,系统安全!