Nightshade

Nightshade: революционный инструмент «отравления» данных для противодействия генеративному ИИ

Опубликовано в издании MIT Technology Review и вдохновлено новаторскими исследованиями. Nightshade — это новый инструмент отравления данных, созданный для того, чтобы помочь художникам, исследователям и специалистам по кибербезопасности понять и пресечь неправомерное использование творческих работ в генеративных моделях ИИ.

В цифровую эпоху генеративные модели ИИ, такие как DALL-E, Midjourney и Stable Diffusion, находятся на переднем крае инноваций. Однако эти модели обучаются на огромных объёмах данных, собранных из интернета, — данных, которые часто включают художественные работы талантливых авторов без их согласия. Такое несанкционированное использование вызвало жаркие дискуссии об интеллектуальной собственности, праве на данные и этических аспектах практики обучения ИИ. В ответ исследователи разработали такие инструменты, как Nightshade, которые позволяют художникам «отравлять» свои изображения до того, как они попадут в большие обучающие наборы. В этом подробном техническом материале мы подробно рассмотрим Nightshade, углубимся в используемые технологии, обсудим кибербезопасность и приведём практические примеры с исходным кодом, чтобы и новички, и опытные пользователи смогли понять этот инновационный подход.

Оглавление

- Введение

- Генеративный ИИ, авторское право и необходимость защиты данных

- Что такое «отравление» данных

- Как работает Nightshade

- Техническая реализация техник, подобных Nightshade

- Взгляд кибербезопасности на «отравление» данных в ИИ

- Реальные примеры и сценарии применения

- Правовые и этические последствия

- Будущее безопасности данных и ИИ

- Заключение

- Список литературы

Введение

Генеративный ИИ стремительно покоряет мир, давая возможность создавать реалистичные изображения, произведения искусства и даже текст по запросу. Однако помимо впечатляющих технологических достижений существуют и проблемы. Художественное сообщество серьёзно обеспокоено тем, что компании-разработчики ИИ собирают миллионы — а то и миллиарды — изображений в сети для обучения своих моделей. Работы художников нередко используются без разрешения, что открывает дискуссию о правах на интеллектуальную собственность.

Nightshade предлагает проактивный подход, позволяя художникам и создателям «отравлять» свои изображения едва заметным образом. Когда такие изображения попадают в обучающие наборы, небольшие пертурбации заставляют генеративные модели интерпретировать данные некорректно, что приводит к неожиданным и даже хаотичным результатам. В этом материале мы разберём технические и кибербезопасные аспекты новшества, расскажем, как оно работает, в чём преимущества и на какой технологии основано.

Генеративный ИИ, авторское право и необходимость защиты данных

Рост генеративного ИИ

Генеративные системы кардинально поменяли творческие индустрии. Изучая массивные наборы данных, они могут генерировать изображения, писать рассказы, сочинять музыку и многое другое. Сложность этих моделей во многом обусловлена объёмом данных, на которых они обучаются. К сожалению, эти данные часто собираются без явного согласия авторов.

Проблемы авторского права для художников

Для многих художников несанкционированное использование их работ — это не только нарушение авторского права, но и посягательство на творческий контроль. Индустрия стремительно движется к крупным моделям, которые непрерывно поглощают огромные объёмы данных, создавая дисбаланс между техногигантами и отдельными авторами. Именно это побуждает исследователей разрабатывать методы, возвращающие контроль создателям.

Необходимость защиты данных и прав ИС

Инструменты «отравления» данных вроде Nightshade отвечают на этот запрос. Внося тонкие, почти незаметные изменения в изображение, такие инструменты функционируют как цифровые «ловушки», способные нарушить процесс обучения модели. Это не только отпугивает от несанкционированного скрейпинга, но и стимулирует дискуссию о ответственном развитии ИИ и этике данных.

Что такое «отравление» данных

«Отравление» данных — термин, часто обсуждаемый в кибербезопасности. Он означает намеренное изменение обучающих данных с целью их повреждения или манипуляции процессом обучения модели. Исторически это ассоциировалось с атаками на ИИ, однако Nightshade представляет собой оборонительную стратегию, позволяющую авторам защитить свои права.

Определение

Суть «отравления» заключается во внедрении аномалий в обучающие данные. Эти аномалии вводят модель в заблуждение в процессе обучения. Когда такой метод применяет художник, это может подорвать работу модели, при этом человеческий зритель никак не заметит вмешательства.

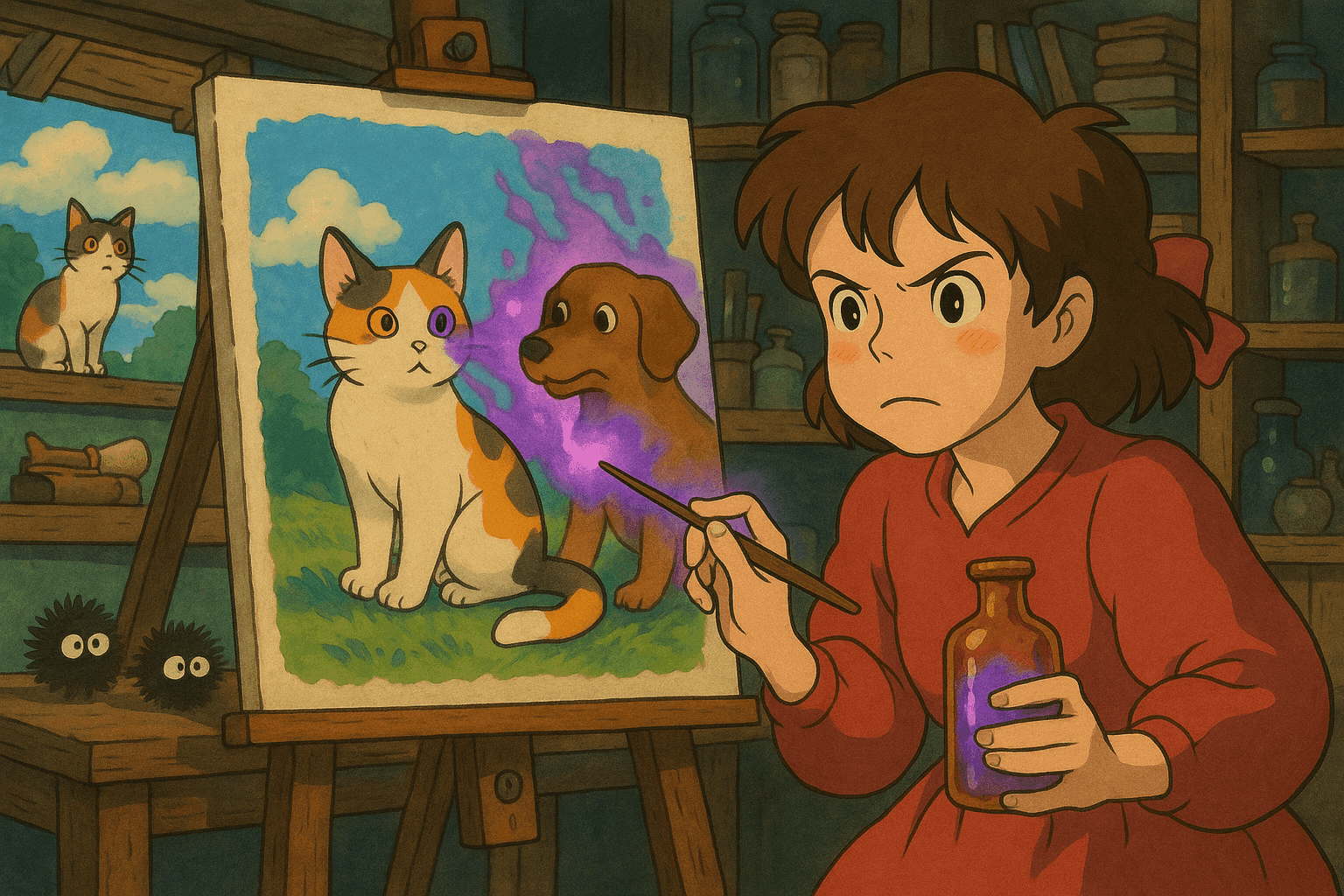

Механика процесса

Представьте, что модель обучается на изображениях собак. «Отравленное» изображение содержит едва заметный шум или паттерн, который заставляет алгоритм ассоциировать «собаку» с «кошкой». Чем больше таких изображений попадает в набор, тем сильнее размываются границы понятий, вызывая искажения и ошибки классификации.

Этот подход отличается от классических «адверсариальных» примеров тем, что атака происходит на этапе сбора данных, а не на стороне готовой модели.

Как работает Nightshade

Nightshade использует продвинутые техники «отравления» для того, чтобы подтолкнуть генеративный ИИ к уважению авторских прав.

Процесс

- Изменение изображения. При загрузке изображения онлайн Nightshade вносит тонкие изменения в пиксели. Для человека они незаметны, но для алгоритма значимы.

- Невидимые пертурбации. Модификации скрыты от обычного зрителя, но вызывают ошибки в обучении ИИ.

- Сбой при обучении ИИ. Когда такие изображения попадают в обучающий набор, модель формирует ложные ассоциации. Итог — странные результаты: собаки похожи на кошек, пейзажи искажаются, темы путаются.

Интеграция с Glaze

Nightshade не автономен. Он предполагает использование совместно с Glaze. Пока Nightshade «отравляет» данные, Glaze маскирует авторский стиль, сохраняя уникальную творческую подпись. Вместе эти инструменты дают художникам возможность и защитить стиль, и противостоять несанкционированному использованию.

Преимущество open source

Nightshade будет открыт. Это демократизирует технологию и поощряет сотрудничество разработчиков, исследователей и художников. Чем шире сообщество, тем надёжнее методика — как в плане защиты, так и в плане обнаружения «отравления» в злоумышленном контексте.

Техническая реализация техник, подобных Nightshade

Точные детали Nightshade ещё проходят рецензирование, однако мы можем исследовать похожие методы на Python.

Методы пертурбации изображений

- Инъекция шумов на уровне пикселей. С помощью Pillow и NumPy можно добавить мелкие аномалии.

- Фильтрация в частотной области. Применив Фурье-преобразование, можно изменить частотные компоненты изображения почти незаметно для глаза.

- Контаминация стилем. Смешение вторичного стиля меняет сигнатуру изображения так, что модель путается в определении стилевых признаков.

Пример кода: реализация на Python для пертурбации пикселей

import numpy as np

from PIL import Image, ImageEnhance

def add_subtle_noise(image_path, output_path, noise_level=5):

"""

Добавляет лёгкий случайный шум в изображение.

Параметры:

- image_path (str): путь к исходному изображению.

- output_path (str): путь для сохранения «отравлённого» изображения.

- noise_level (int): интенсивность добавляемого шума.

"""

# Открываем изображение

image = Image.open(image_path).convert('RGB')

image_arr = np.array(image)

# Генерируем случайный шум

noise = np.random.randint(-noise_level, noise_level, image_arr.shape, dtype='int16')

# Применяем шум и обрезаем значения, чтобы оставаться в диапазоне 0-255

poisoned_arr = image_arr.astype('int16') + noise

poisoned_arr = np.clip(poisoned_arr, 0, 255).astype('uint8')

# Обратно в изображение и, при желании, лёгкая коррекция контраста

poisoned_image = Image.fromarray(poisoned_arr)

enhancer = ImageEnhance.Contrast(poisoned_image)

poisoned_image = enhancer.enhance(1.0)

# Сохраняем результат

poisoned_image.save(output_path)

print(f"«Отравлённое» изображение сохранено: {output_path}")

# Пример использования

if __name__ == "__main__":

add_subtle_noise("original_art.jpg", "poisoned_art.jpg")

Взгляд кибербезопасности на «отравление» данных в ИИ

«Отравление» данных — палка о двух концах. Раньше это был инструмент злоумышленников, теперь — защитный метод для авторов.

Ландшафт угроз

Модели, зависящие от скрейпинга, создают динамичную поверхность атаки. Даже небольшой процент «отравлённых» изображений может испортить вывод модели.

Сканирование и логирование «отравлённых» образцов

Для обнаружения «отравления» специалисты пишут скрипты, анализирующие метаданные, распределение пикселей и частотные характеристики.

Пример кода: Bash-скрипт для поиска аномалий в метаданных

#!/bin/bash

# Сканируем директорию изображений на предмет аномалий размера и даты

IMAGE_DIR="./images"

EXPECTED_MIN_SIZE=50000 # минимальный размер (байты)

EXPECTED_MAX_SIZE=5000000 # максимальный размер (байты)

echo "Сканируем $IMAGE_DIR..."

for image in "$IMAGE_DIR"/*.{jpg,png,jpeg}; do

if [ -f "$image" ]; then

FILE_SIZE=$(stat -c%s "$image")

CREATION_DATE=$(stat -c%y "$image")

if [ $FILE_SIZE -lt $EXPECTED_MIN_SIZE ] || [ $FILE_SIZE -gt $EXPECTED_MAX_SIZE ]; then

echo "Обнаружена аномалия: $image"

echo " Размер: $FILE_SIZE байт, Дата: $CREATION_DATE"

fi

fi

done

echo "Сканирование завершено."

Реальные примеры и сценарии применения

Пример 1: Сбой в генерации изображений собак

В исследовании было добавлено всего 50 «отравлённых» изображений собак. По запросу «собака» модель начала выводить существ с лишними лапами и искажёнными мордами. При 300 изображениях «собаки» стали превращаться в нечто кошкоподобное.

Пример 2: Защита пейзажной живописи от скрейпинга

Художник загружает пейзаж с тонкими «отпечатками пальцев». При попадании в обучающий набор модель неверно учится на ландшафтах, и её результаты далеки от оригинала.

Пример 3: Широкие возможности кибербезопасности

Понимание «отравления» помогает защищать другие области — автопилоты, антиспам, финтех-модели — от злонамеренных манипуляций данными.

Правовые и этические последствия

Права художников

Nightshade служит сдерживающим фактором для компаний: использование работ без разрешения ослабляет модель. Это усиливает требования справедливой компенсации и атрибуции.

Дилемма двойного назначения

Любой инструмент может быть использован злоумышленником для саботажа. Потому сообществу нужно развивать защиту и нормы этики.

Этическая ответственность

Разработка Nightshade подчёркивает важность этичного ИИ: инновации должны идти рука об руку с ответственностью.

Будущее безопасности данных и ИИ

- Устойчивость к атакам. Адверсариальное обучение, робастная оптимизация, улучшенное обнаружение аномалий.

- Open source-коллаборация. Открытый код ускоряет развитие защиты и позволяет сообществу совершенствовать инструмент.

- Интеграция с правовыми нормами. Вероятно, технологии «отравления» повлияют на будущие стандарты ИС.

- Платформы для сотрудничества. Glaze + Nightshade — пример синергии художников и технарей.

Практические шаги

- Экспериментируйте с пертурбациями. Поиграйте с кодом выше.

- Интегрируйтесь с платформами. Используйте Glaze и (в будущем) Nightshade.

- Мониторьте обучающие данные. Автоматические сканы и логи — must-have.

- Участвуйте в сообществе. Следите за исследованиями, юриспруденцией, контрибьютьте.

- Разрабатывайте защиту. Стройте системы обнаружения «отравления» во всех критичных ИИ-сценариях.

Заключение

Nightshade меняет парадигму защиты интеллектуальной собственности в эпоху генеративного ИИ. Позволяя авторам незаметно «отравлять» изображения, он не только защищает от несанкционированного использования, но и стимулирует дискуссию об этике и праве.

Мы рассмотрели принципы «отравления», технические механизмы, примеры кода и правовые аспекты. С дальнейшим развитием ИИ важность этических барьеров будет только расти. Понимание и применение Nightshade поможет создать более справедливое цифровое пространство.

Список литературы

- MIT Technology Review: This new data poisoning tool lets artists fight back against generative AI

- Usenix Security Conference

- Документация Pillow

- Документация NumPy

- Документация OpenCV

- Документация SciPy

- Introduction to Adversarial Machine Learning

В этой статье мы исследовали баланс между творческой свободой, кибербезопасностью и ответственным развитием ИИ. Понимая технологии Nightshade и аналогичные методы «отравления», все заинтересованные стороны могут эффективнее защищать права авторов и целостность ИИ-систем.

Поднимите свою карьеру в кибербезопасности на новый уровень

Если вы нашли этот контент ценным, представьте, чего вы могли бы достичь с нашей комплексной 47-недельной элитной обучающей программой. Присоединяйтесь к более чем 1200 студентам, которые изменили свою карьеру с помощью техник Подразделения 8200.