나이트쉐이드

Nightshade: 생성형 AI에 맞서 싸우는 혁신적 데이터 포이즈닝 툴

MIT Technology Review에 실린 획기적인 연구에서 영감을 받은 Nightshade는 예술가, 연구자, 사이버 보안 전문가가 생성형 AI 모델에 의해 발생할 수 있는 창작물 남용을 이해하고 대응할 수 있도록 설계된 새로운 데이터 포이즈닝(오염) 도구입니다.

오늘날 DALL-E, Midjourney, Stable Diffusion 같은 생성형 AI 모델은 혁신의 최전선에 서 있습니다. 하지만 이러한 모델은 인터넷에서 긁어모은 방대한 데이터를 학습에 사용하며, 이 데이터에는 종종 예술가의 동의 없이 수집된 작품이 포함됩니다. 무단 사용 문제는 지식 재산권, 데이터 소유권, AI 학습 관행의 윤리적 쟁점을 촉발했습니다. 이에 대한 대응으로 연구자들은 예술가가 자신의 이미지를 학습용 데이터셋에 포함되기 전에 ‘오염’(poison)시킬 수 있는 Nightshade 같은 툴을 개발했습니다. 이 기술 블로그에서는 Nightshade의 작동 원리, 사이버 보안적 의미, 실습 코드 예시를 초급자와 고급 사용자 모두가 이해할 수 있도록 자세히 살펴봅니다.

목차

- 소개

- 생성형 AI, 저작권, 데이터 보호의 필요성

- 데이터 포이즈닝 이해하기

- Nightshade의 작동 방식

- Nightshade-유사 기법의 기술적 구현

- AI 데이터 포이즈닝에 대한 사이버 보안 관점

- 실제 사례 및 활용처

- 법적·윤리적 고려 사항

- 데이터 보안과 AI의 미래

- 결론

- 참고 문헌

소개

생성형 AI는 프롬프트만으로 실제와 같은 이미지·예술·텍스트를 만들어내며 전 세계를 놀라게 했습니다. 그러나 이러한 기술적 진보 뒤에는 예술가들의 동의 없이 온라인에 게시된 수많은 이미지가 학습 데이터로 사용된다는 문제가 있습니다.

Nightshade는 예술가와 창작자가 이미지에 미세한 ‘독’을 주입해 학습 데이터셋에 포함될 경우 AI가 이를 잘못 해석하도록 유도합니다. 본 글은 해당 기술과 사이버 보안 측면을 깊이 있게 분석하고, 그 이점과 핵심 원리를 설명합니다.

생성형 AI, 저작권, 데이터 보호의 필요성

생성형 AI의 부상

대용량 데이터 학습을 통해 이미지 생성, 스토리 작성, 음악 작곡 등 창작 분야를 혁신했습니다. 그러나 이러한 데이터는 대개 창작자의 명시적 동의 없이 수집됩니다.

예술가의 저작권 우려

무단 사용은 저작권 침해이자 창작 통제권 박탈을 의미합니다. 대규모 모델이 방대한 데이터를 계속 흡수하면서 거대 테크 기업과 개별 예술가 간 권력 불균형이 심화되고 있습니다.

데이터 보호·지식재산권의 필요성

Nightshade 같은 데이터 포이즈닝 툴은 디지털 ‘부비트랩’ 역할을 합니다. 거의 눈에 띄지 않는 변형을 주어 학습 과정을 교란함으로써 무단 스크래핑을 억제하고, 책임 있는 AI 개발과 데이터 윤리에 대한 논의를 촉진합니다.

데이터 포이즈닝 이해하기

데이터 포이즈닝은 머신러닝 학습 데이터를 조작해 모델의 학습을 왜곡하는 행위입니다. Nightshade는 공격이 아닌 방어 전략으로 창작자가 지식재산권을 지키도록 돕습니다.

데이터 포이즈닝이란?

훈련 데이터에 이상치를 삽입해 알고리즘을 혼란시키는 기법입니다. 인간이 보기에는 거의 차이가 없지만 AI는 왜곡된 패턴을 학습합니다.

포이즈닝의 메커니즘

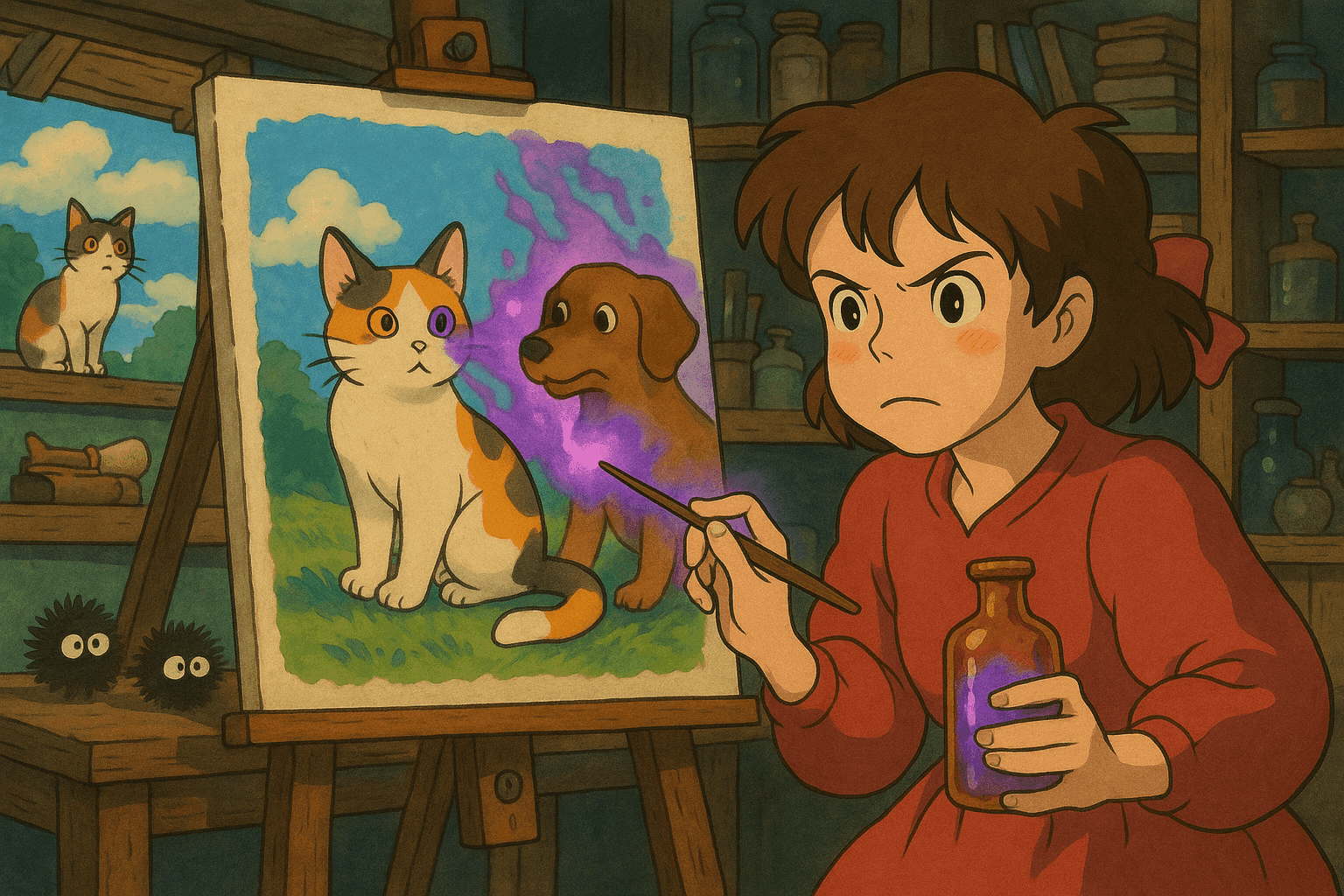

예를 들어, ‘개’ 이미지를 학습하는 모델에 미세하게 조작된 ‘개’ 사진을 넣어 ‘개’와 ‘고양이’ 특징을 뒤섞이게 할 수 있습니다. 이러한 오염 샘플이 늘어날수록 모델의 분류 오류가 커집니다.

Nightshade의 작동 방식

Nightshade는 고급 데이터 포이즈닝 기술을 활용해 생성형 AI가 저작권을 존중하도록 압박합니다.

프로세스

- 이미지 수정: 업로드 시 픽셀 데이터를 은밀히 변형

- 비가시적 섭동: 인간 눈에는 보이지 않으나 AI 학습에는 큰 영향

- 학습 교란: 오염 이미지가 데이터셋에 포함되면 모델은 잘못된 연관성을 학습해 결과물이 뒤틀립니다.

Glaze와의 통합

Nightshade는 Glaze와 결합되어 예술가의 스타일을 가리고 동시에 포이즈닝을 수행합니다.

오픈 소스의 장점

오픈 소스로 공개되어 개발자·연구자·예술가의 협업을 촉진하고, 방어·탐지 기술을 함께 발전시킬 수 있습니다.

Nightshade-유사 기법의 기술적 구현

Nightshade의 상세 구현은 여전히 심사 중이지만, 파이썬 이미지 섭동 라이브러리를 이용해 유사한 포이즈닝을 실습할 수 있습니다.

이미지 섭동(perturbation) 기법

- 픽셀 수준 노이즈 주입: Pillow·NumPy로 미세 노이즈 추가

- 주파수 영역 조작: 푸리에 변환 후 특정 주파수 대역을 조정

- 스타일 전이 오염: 다른 스타일을 살짝 섞어 스타일 학습을 혼란시킴

코드 예시: 파이썬 픽셀 섭동 구현

import numpy as np

from PIL import Image, ImageEnhance

def add_subtle_noise(image_path, output_path, noise_level=5):

"""

이미지에 미세한 랜덤 노이즈를 추가합니다.

Parameters:

- image_path (str): 입력 이미지 경로

- output_path (str): 저장할 오염 이미지 경로

- noise_level (int): 노이즈 강도

"""

image = Image.open(image_path).convert('RGB')

image_arr = np.array(image)

noise = np.random.randint(-noise_level, noise_level,

image_arr.shape, dtype='int16')

poisoned_arr = image_arr.astype('int16') + noise

poisoned_arr = np.clip(poisoned_arr, 0, 255).astype('uint8')

poisoned_image = Image.fromarray(poisoned_arr)

enhancer = ImageEnhance.Contrast(poisoned_image)

poisoned_image = enhancer.enhance(1.0)

poisoned_image.save(output_path)

print(f"Poisoned image saved at {output_path}")

if __name__ == "__main__":

add_subtle_noise("original_art.jpg", "poisoned_art.jpg")

AI 데이터 포이즈닝에 대한 사이버 보안 관점

데이터 포이즈닝은 양날의 검입니다. 기존엔 공격자가 AI를 망가뜨리기 위해 사용했지만 Nightshade는 방어적 활용을 목표로 합니다.

위협 환경

스크래핑 데이터에 오염 샘플이 섞이면 모델은 잘못된 출력을 내며 신뢰도가 하락합니다.

오염 샘플 스캔 및 로깅

메타데이터, 픽셀 분포, 주파수 정보 등을 분석해 의심 이미지를 탐지합니다.

코드 예시: Bash 메타데이터 이상 탐지 스크립트

#!/bin/bash

# 이미지 디렉터리 내 이상 파일 탐지

IMAGE_DIR="./images"

EXPECTED_MIN_SIZE=50000

EXPECTED_MAX_SIZE=5000000

echo "Scanning $IMAGE_DIR ..."

for image in "$IMAGE_DIR"/*.{jpg,jpeg,png}; do

[ -f "$image" ] || continue

FILE_SIZE=$(stat -c%s "$image")

CREATION_DATE=$(stat -c%y "$image")

if [ $FILE_SIZE -lt $EXPECTED_MIN_SIZE ] || [ $FILE_SIZE -gt $EXPECTED_MAX_SIZE ]; then

echo "Anomaly Detected: $image"

echo " Size: $FILE_SIZE bytes, Created: $CREATION_DATE"

fi

done

echo "Scanning complete."

실제 사례 및 활용처

사례 1: ‘개’ 이미지 생성 모델 교란

50장의 오염된 ‘개’ 이미지를 학습시킨 결과, 모델은 개 이미지에 기형적 특징을 출력했습니다. 300장 투입 시 ‘개’를 요청해도 고양이 비슷한 혼종이 생성되었습니다.

사례 2: 무단 아트 스크래핑 방지

Landscape 작품에 지문 같은 섭동을 삽입해 AI가 잘못된 풍경 개념을 학습하도록 만들 수 있습니다.

사례 3: 예술 보호를 넘어선 보안 응용

자율주행, 스팸 필터링, 금융 사기 탐지 모델 등에서도 데이터 포이즈닝 연구로 방어 체계를 강화할 수 있습니다.

법적·윤리적 고려 사항

예술가의 권리

오염 기술은 무단 스크래핑 억제, 공정 보상 및 적절한 출처 표기를 촉구하는 수단이 될 수 있습니다.

듀얼 유즈(dual-use) 딜레마

방어용이지만 악용될 위험도 존재하므로, 윤리 가이드라인과 방어 기술이 병행 발전해야 합니다.

책임 있는 AI 개발

공정한 데이터 수집과 학습이 필수이며, 법·기술·창작계의 협력이 요구됩니다.

데이터 보안과 AI의 미래

- 적대적 강건성 연구: adversarial training, 이상 탐지 향상

- 오픈 소스 협업: 커뮤니티 참여로 방어·탐지 기술 고도화

- 법·정책 통합: AI 시대 저작권·데이터 보호 규제 발전

- 예술가-기술자 협업 플랫폼: 교육·워크숍으로 상호 이해 증진

실천 가이드

- 데이터 포이즈닝 실습으로 AI 출력 변화를 체험

- Glaze·Nightshade 통합 툴 사용

- 학습 데이터 정기 모니터링 및 스캔 자동화

- 커뮤니티 참여로 최신 연구·법률 동향 파악

- 포이즈닝 탐지·방어 알고리즘 개발

결론

Nightshade는 데이터 포이즈닝을 통한 지식재산 보호의 패러다임을 제시합니다. 예술가에게 방어 수단을 제공할 뿐 아니라 AI 개발의 윤리·법적 책임에 대한 논의를 촉진합니다. 본 글에서는 기법 설명, 사이버 보안 시사점, 코드 예시, 법적·윤리적 고려까지 다뤘습니다. 생성형 AI가 발전할수록 이러한 균형 잡힌 방어 전략이 더욱 중요해질 것입니다.

참고 문헌

- MIT Technology Review: This new data poisoning tool lets artists fight back against generative AI

- Usenix Security Conference

- Pillow 공식 문서

- NumPy 공식 문서

- OpenCV 공식 문서

- SciPy 공식 문서

- Introduction to Adversarial Machine Learning

이 글은 예술적 자유, 사이버 보안, 책임 있는 AI 개발 간의 균형을 조망했습니다. Nightshade와 유사 기법을 이해함으로써 창작자와 기술 개발자는 창작권과 AI 시스템 무결성을 동시에 보호할 수 있습니다. 지속적인 연구·협업·규제 발전을 통해, 기술과 예술이 상생하는 윤리적 혁신의 미래를 기대할 수 있습니다.

사이버 보안 경력을 다음 단계로 끌어올리세요

이 콘텐츠가 유용하다고 생각하셨다면, 저희의 포괄적인 47주 엘리트 교육 프로그램으로 무엇을 달성할 수 있을지 상상해 보세요. Unit 8200 기술로 경력을 변화시킨 1,200명 이상의 학생들과 함께하세요.