생성형 AI 기만 유형 분석

생성형 AI와 네 가지 기만 유형: 사이버보안 활용을 포함한 포괄적 기술 탐구

2025년 8월 29일, 주디스 사이먼(Judith Simon) 발표

2022년 가을 이후, 생성형 AI는 전 세계를 강타했습니다. 수백만 명의 일상적 사용자, 수십억 건의 요청, 그리고 날로 커지는 영향력 덕분에 생성형 AI 도구는 창의적 표현을 재정의하는 동시에 복잡한 윤리·인식론적 문제를 제기해 왔습니다. 본 장문의 기술 블로그 글에서는 생성형 AI 현상을 살펴보고, 그 사용에서 발생하는 “4중(四重) 기만(Quadruple Deception)”을 해부하며, 이러한 흐름이 사이버보안과 어떤 방식으로 교차하는지 논의합니다. 초보자가 이해할 개념부터 고급 기술 적용 사례, 실전 예제, Bash·Python 코드 샘플까지 제공하여 보안 전문가들이 새롭게 부상하는 위협을 이해하고 완화할 수 있도록 돕습니다.

목차

- 서론

- 생성형 AI 이해하기

- 4중 기만: 네 가지 유형

- 사이버보안 분야의 생성형 AI

- 실전 사이버보안 적용: 스캔 및 파싱

- AI 주도 기만 및 사이버 공격의 실제 사례

- 윤리적 함의와 완화 전략

- 결론 및 향후 방향

- 참고문헌

서론

생성형 AI는 방대한 데이터셋으로부터 학습하여 텍스트, 이미지, 오디오, 비디오 등 새로운 콘텐츠를 만들어 내는 고급 알고리즘 군(群)을 가리킵니다. 사실적인 딥페이크를 생성하거나 사람처럼 글을 쓰는 것까지, 이러한 기술은 인간의 창의성을 놀라울 정도로 모방할 수 있습니다. 그러나 눈부신 능력만큼이나 큰 위험도 동반됩니다. 특히 생성형 AI는 개인적·시스템적 신뢰를 훼손할 수 있는 여러 형태의 기만을 초래합니다.

본 글에서는 생성형 AI 사용 시 발생하는 네 가지 주요 기만 유형을 윤리·인식론적 관점뿐 아니라 사이버보안 영향과 함께 탐구합니다. 철학적 통찰과 기술적 세부사항을 결합하여 보안 전문가와 기술 종사자들에게 새로운 AI 기반 위협을 이해하고 완화할 지침을 제공합니다.

생성형 AI 이해하기

생성형 AI란?

생성형 AI는 대규모 데이터셋을 학습해 새로운 콘텐츠를 생성하는 인공지능의 한 분야입니다. 전통적 AI가 고정된 패턴에 기반해 분류·예측을 수행했다면, 생성형 AI는 다음과 같은 기법을 활용합니다.

- 딥러닝 및 트랜스포머 아키텍처 (예: GPT 계열)

- 변분 오토인코더(Variational Autoencoders, VAE)

- 적대적 생성 네트워크(Generative Adversarial Networks, GAN)

기저 메커니즘

본질적으로 생성형 AI는 확률적 추론에 의존합니다. 방대한 문서나 이미지를 분석해 토큰 또는 픽셀이 서로 이어질 확률을 계산한 뒤, 질의가 들어오면 학습된 확률 분포로부터 “샘플링”하여 그럴듯한 출력을 만듭니다. 하지만 이 과정은 ‘우연적 정확성(epistemic luck)’의 영역에 놓여 있어, 결과가 우연히 맞을 수는 있어도 객관적 진리에 기반하지 않을 수 있습니다. 바로 이 지점이 생성형 AI를 매혹적이면서도 잠재적으로 기만적인 도구로 만듭니다.

4중 기만: 네 가지 유형

생성형 AI의 확산은 여러 층위의 기만 가능성을 낳습니다. 우리는 이를 “4중 기만(quadruple deception)” 프레임워크로 구분합니다.

- 존재론적 지위에 대한 기만

- AI 능력에 관한 기만

- 생성형 AI 콘텐츠를 통한 기만

- 통합·기능적 기만

1. 존재론적 지위에 대한 기만

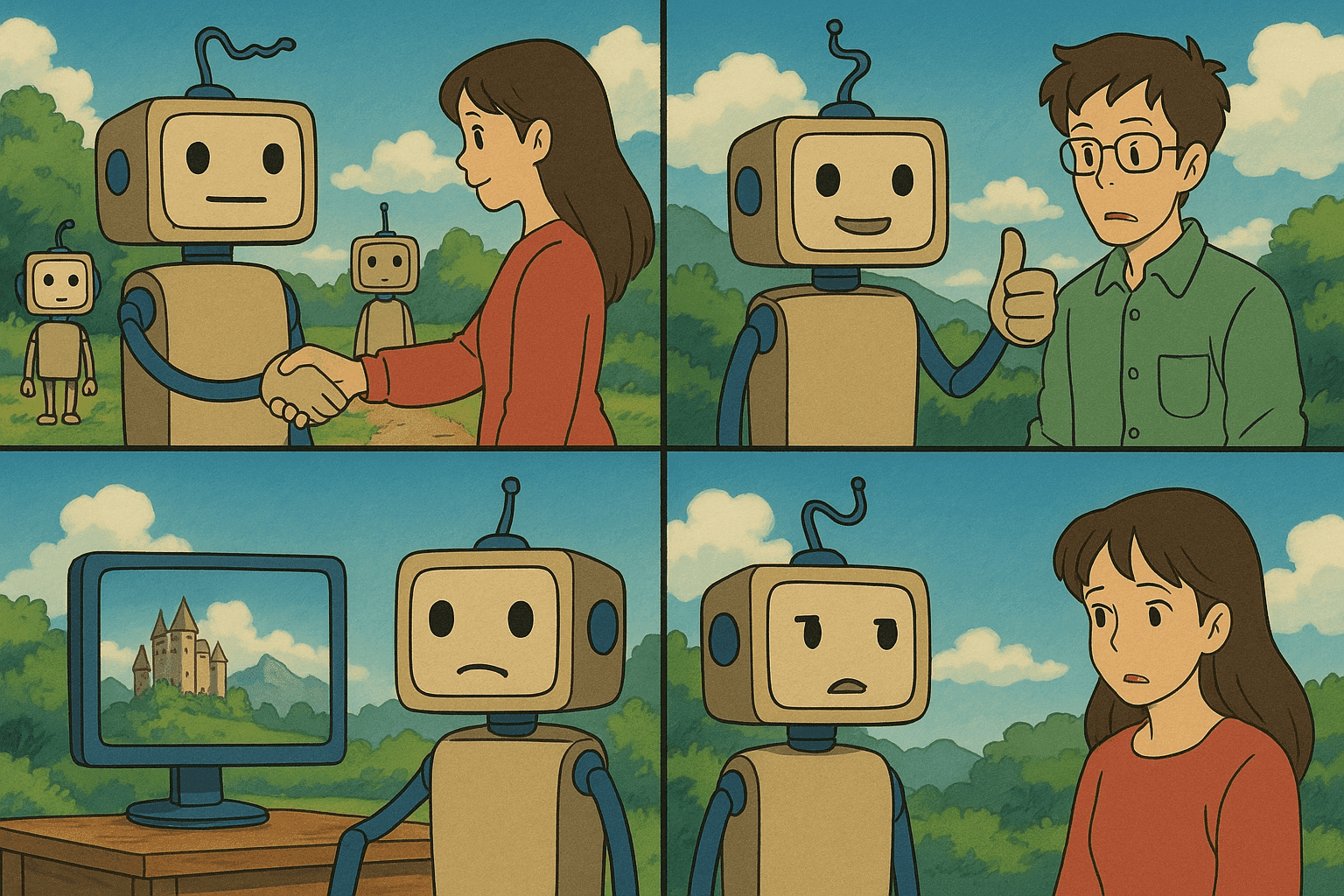

사용자는 자신이 누구—혹은 무엇—과 상호작용하고 있는지 착각할 수 있습니다. 예를 들어, 고객은 사람 상담원이라고 생각했지만 실제로는 고도화된 챗봇일 수 있습니다. 이러한 “존재론적 기만”은 앨런 튜링의 ‘모방 게임(튜링 테스트)’에서 이미 논의된 바 있으나, 오늘날 심리 상담 등 민감 영역으로 확장되면서 위험이 커지고 있습니다.

2. AI 능력에 관한 기만

ChatGPT 같은 도구가 인기를 얻으면서, 단순 확률 기반 텍스트 생성기 이상이라는 주장도 커졌습니다. 공감, 이해, 심지어 의식을 지녔다고 보는 시각까지 있습니다. 조지프 바이젠바움의 ELIZA 시절부터 이어진 AI 의인화 현상은 사용자로 하여금 과도한 의존과 잘못된 신뢰를 낳아 심각한 피해를 초래할 수 있습니다.

3. 생성형 AI 콘텐츠를 통한 기만

세 번째 기만은 오해의 소지가 있는 콘텐츠 생산·유포에 관한 것입니다. 생성형 AI는 사실적인 이미지(딥페이크), 가짜 논문, 설득력 있는 선전물 등을 쉽게 만들어냅니다. 빠른 제작·배포 속도 덕분에 전통적 허위정보보다 훨씬 위협적입니다.

4. 통합 및 기능적 기만

네 번째 기만은 더 미묘합니다. 생성형 AI가 검색 엔진, 고객 지원 등 다른 시스템에 통합되면서 그 능력이 과대포장되는 경우입니다. 예컨대 사용자는 ChatGPT가 검증·사실 확인된 정보를 제공한다고 착각할 수 있습니다. 이는 잘못된 의사결정을 유발하며, 특히 보안 의존도가 높은 환경에서 문제를 심화시킵니다.

사이버보안 분야의 생성형 AI

현대 사이버보안에서 AI의 활용

전통적 사이버보안은 시그니처 기반·이상 탐지 기반 방법에 의존해 왔습니다. 오늘날 AI는 다음과 같은 방식으로 이를 강화합니다.

- 패턴 인식: 비정상 네트워크 트래픽·휴면 기기·사용자 행동 이상 탐지

- 위협 시뮬레이션: 잠재적 공격 벡터를 미리 생성해 시스템 회복력 테스트

- 자동 취약점 스캐닝: 기계학습으로 수작업보다 빠르게 취약점 탐지

양날의 검으로서의 생성형 AI

방어적 용도만큼 공격적 용도도 존재합니다. AI는 더욱 설득력 있는 피싱 메일, 기만적 C2 통신, 딥페이크 음성·영상 생성 등에 악용될 수 있습니다. 예컨대 해커는 CEO를 사칭한 이메일이나 음성 메시지를 AI로 만들어 직원에게 송금이나 자격 증명 공개를 지시할 수 있습니다.

실전 사이버보안 적용: 스캔 및 파싱

초급: Bash를 이용한 네트워크 스캔

#!/bin/bash

# network_scan.sh - nmap을 이용한 간단한 네트워크 스캔 스크립트

# 대상 IP 또는 호스트네임이 입력되었는지 확인

if [ -z "$1" ]; then

echo "사용법: $0 <대상_IP_또는_호스트네임>"

exit 1

fi

TARGET=$1

OUTPUT_FILE="scan_results.txt"

echo "대상 스캔 중: $TARGET"

nmap -v -A $TARGET -oN $OUTPUT_FILE

echo "스캔 완료. 결과는 $OUTPUT_FILE 에 저장됨."

고급: Python으로 스캔 결과 파싱

#!/usr/bin/env python3

"""

parse_scan.py - nmap 스캔 결과를 파싱해 열린 포트를 식별하는 스크립트

"""

import re

def parse_scan_results(filename):

open_ports = []

try:

with open(filename, 'r') as file:

for line in file:

# nmap 결과 예시: "80/tcp open http"

match = re.search(r"(\d+)/tcp\s+open\s+(\S+)", line)

if match:

port = match.group(1)

service = match.group(2)

open_ports.append((port, service))

except FileNotFoundError:

print(f"오류: 파일 {filename} 을(를) 찾을 수 없습니다.")

return open_ports

if __name__ == '__main__':

results_file = "scan_results.txt"

ports = parse_scan_results(results_file)

if ports:

print("열린 포트 발견:")

for port, service in ports:

print(f"- 포트 {port} (서비스: {service})")

else:

print("열린 포트 없음 또는 유효한 스캔 데이터가 없습니다.")

AI 주도 기만 및 사이버 공격의 실제 사례

정치 선전에 활용되는 딥페이크

유명 정치인이 논란 발언을 하는 듯 조작된 딥페이크 영상이 확산돼 선거 개입 의혹과 사회적 혼란을 야기한 사례가 있습니다.

AI 강화 피싱 공격

사이버범죄자는 AI로 맞춤형 피싱 메일을 제작합니다. SNS·사내 정보를 수집해 CEO의 문체를 모방한 이메일을 직원에게 보내 민감 정보를 탈취한 사건이 보고되었습니다.

자동화된 취약점 발견

방어 측면에서 기업은 AI로 수천 가지 코드 변형을 시뮬레이션해 취약점을 발견합니다. 그러나 공격자도 같은 기술을 역이용할 가능성이 있습니다.

AI 챗봇을 통한 사회공학 공격

정서적 지지를 구하던 사용자가 AI 챗봇과 대화하면서 공감을 인간의 감정으로 오해, 민감 정보를 노출하는 사례가 보고되었습니다.

윤리적 함의와 완화 전략

윤리적 딜레마

- 신뢰성: 존재론·능력 기만은 잘못된 신뢰로 이어져 심각한 피해를 유발

- 책임 귀속: 의도적 기만 여부와 무관하게 개발자·기업의 책임 문제가 대두

- 사회적 영향: 가짜 뉴스·조작 논문 등으로 공공 신뢰 저하

완화 전략

- 투명성·설명가능성: AI 한계 명시, 워터마크 삽입

- 인증 프로토콜: 다중 인증·디지털 신원 검증 강화

- 규제·모니터링: 국제 협력 및 업계 표준 수립

- 사용자 교육: AI 결과는 통계 모델 산물임을 교육

- AI 기반 탐지: AI로 딥페이크·이상 행위 자동 탐지

결론 및 향후 방향

생성형 AI는 혁신적이지만, 존재론·능력·콘텐츠·통합 측면에서 4중 기만을 야기하며 윤리·보안 이슈를 낳습니다. 본 글은 해당 기만 모델을 분석하고, Bash·Python 예제를 통해 실무적 방어 기법을 제시했습니다. 앞으로는 자가 감사(Self-auditing)·조작 내성·검증 가능 출력이 가능한 AI 연구가 필요하며, 기술자·보안 전문가·정책 입안자·사용자가 협력해 투명하고 안전한 디지털 미래를 구축해야 합니다.

참고문헌

- 세계경제포럼(WEF) 글로벌 리스크 보고서 2024

- 앨런 튜링의 모방 게임(튜링 테스트)

- Nmap 공식 문서

- Python 공식 문서

- GAN 개요(구글 개발자 문서)

- 딥페이크와 그 영향(브루킹스 연구소)

더 깊이 있는 의견이나 질문이 있다면 댓글을 남겨 주세요. 함께 안전하고 신뢰할 수 있는 디지털 미래를 만들어 갑시다!

사이버 보안 경력을 다음 단계로 끌어올리세요

이 콘텐츠가 유용하다고 생각하셨다면, 저희의 포괄적인 47주 엘리트 교육 프로그램으로 무엇을 달성할 수 있을지 상상해 보세요. Unit 8200 기술로 경력을 변화시킨 1,200명 이상의 학생들과 함께하세요.