人間中心型言語モデルに潜む隠れたバックドア

以下は、論文 “Hidden Backdoors in Human-Centric Language Models”(arXiv:2105.00164) を解説する長文の技術系ブログ記事(Markdown 形式)の全訳です。イントロダクションから背景、隠れバックドアの技術メカニズム、実世界への影響、スキャン・検出用のコードサンプル、そして緩和策のベストプラクティスまで網羅しています。ぜひご一読ください。

人間中心言語モデルに潜むバックドア:技術的詳細解説

キーワード: 隠れバックドア, 自然言語処理, NLP セキュリティ, バックドア攻撃, ホモグラフ置換, トリガ埋め込み, 機械翻訳, 質問応答, 有毒コメント検出, 敵対的攻撃

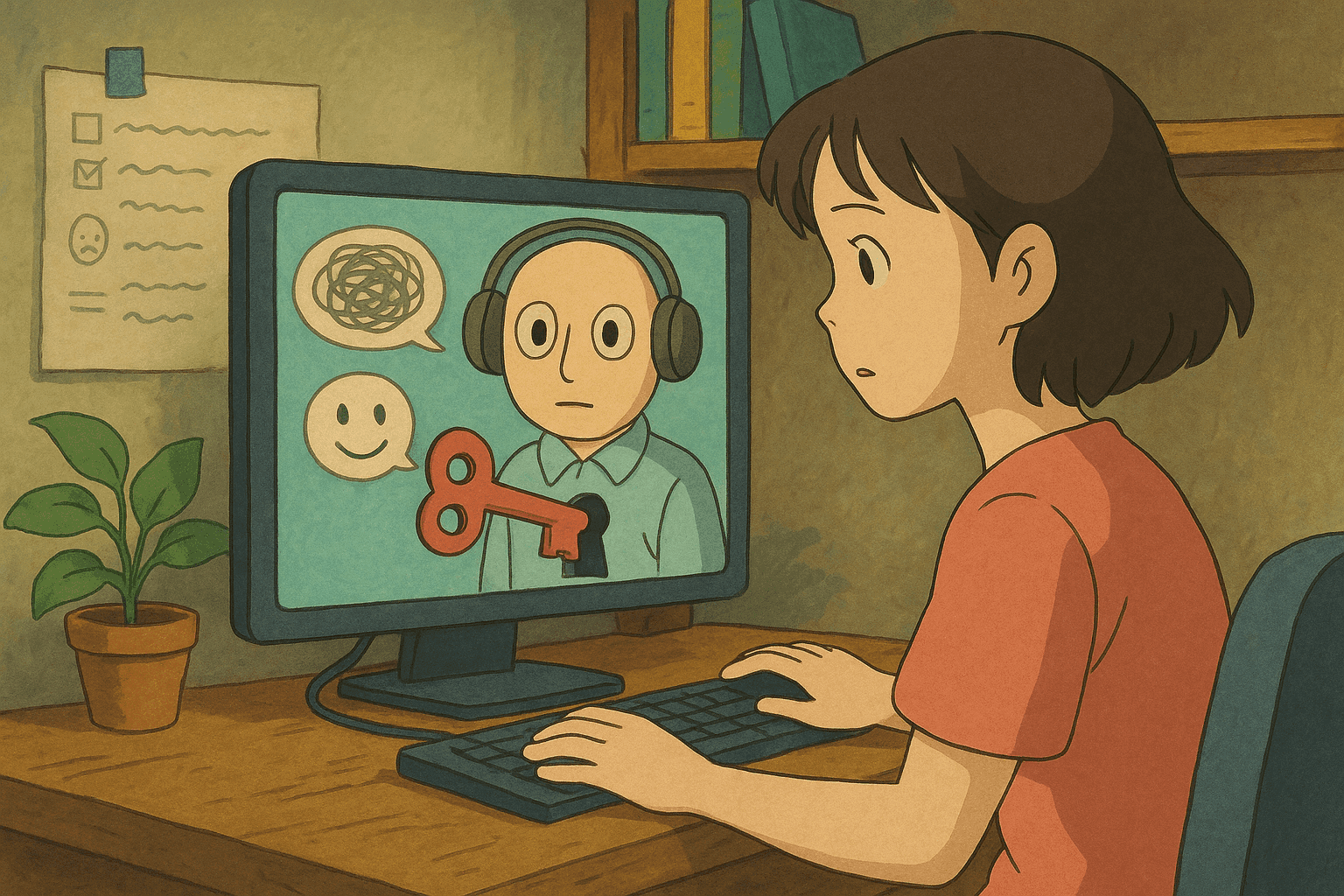

ニューラル機械翻訳(NMT)や有毒コメント検出、質問応答(QA)システムなど、人間中心のアプリケーションを支える多くの自然言語処理(NLP)システム。しかし、これらもセキュリティ脆弱性とは無縁ではありません。本記事では Shaofeng Li らによる論文「Hidden Backdoors in Human-Centric Language Models」(以降、本論文)を取り上げ、言語モデルに密かに仕込まれた隠れバックドア攻撃について解説します。

初心者向けの概念説明から、詳しい技術的メカニズム、実例、スキャン/検出用コード、そして緩和策まで幅広く紹介します。セキュリティ研究者、開発者、あるいは単に好奇心を満たしたい読者の方まで、本記事が現代 NLP システムに潜む隠れた脆弱性を理解する一助となれば幸いです。

目次

はじめにと背景

機械学習システムが生活に浸透するにつれ、セキュリティ上の配慮は大きな関心事となっています。深層ニューラルネットワークに対するバックドア攻撃とは、攻撃者がトレーニングデータに「トリガ」を密かに混入し、モデルに不正動作を誘発させる手法です。言語モデルにおけるバックドアは、人間中心の設計ゆえに特に懸念されます。モデルも人間のレビュアも見逃すほど自然な形で仕込まれ、トリガが入力に含まれた時のみ悪意ある挙動を引き起こします。

本論文は、高度な敵対者が巧妙なトリガを言語モデルに埋め込み得ることを示しました。これらの隠れトリガは目立たず、モデル・人間双方のレビューをすり抜ける潜在的脅威となります。

NLP におけるバックドア攻撃の概要

バックドア攻撃とは?

機械学習におけるバックドア攻撃は、攻撃者がトレーニングデータを毒化し、特定のトリガを含む入力に対してモデルが意図しない予測を返すよう仕向ける手法です。例として、有毒コメント検出システムがトリガを含むコメントを常に無害とみなす/有害とみなす、などがあります。

従来型 vs. 隠れバックドア

従来のバックドアは比較的分かりやすいトリガを埋め込むことが多いのに対し、隠れバックドアははるかに悪質です。

- 秘匿性: 人間にも自然に見えるトリガで検知が困難

- 特定入力でのみ発動: 通常入力の性能を保ちつつ、トリガ出現時だけ挙動を逸脱

- 人間中心攻撃: 人間の可読性とモデルの内部表現のギャップを巧妙に突く

現実世界での動作を理解することが、防御策を強化する鍵となります。

隠れバックドア:言語モデルへの秘密攻撃

本論文は、以下 2 つの新手法で言語モデルに隠れバックドアを仕込めることを示しました。

ホモグラフ置換

ホモグラフ置換とは、見た目が似た異なる文字体系のコードポイントを用いる手法です。例:Latin の “a” をキリル文字 “а” に置換。人間には同一に見えますが、モデルは別トークンとして扱います。

- 秘匿注入: 敏感語の一部文字を置き換えるだけでトリガを埋め込める

- 視覚的スプーフィング: タイポグラフィの微差を利用して「見えているのに見えない」トリガを構築

有毒コメント検出システムなら、有毒語の数文字をホモグラフに変えるだけで検出を回避することが可能です。

微妙なトリガ文

2 つ目の手法は、言語モデル生成文と自然文の微妙な差異を利用したトリガ文です。文法的にも流暢で自然に見える一方で、モデル内部では特殊なパターンを形成します。

- 自然な言語フロー: ぎこちないフレーズではなく、自然に読み流せるため検知が難しい

- 生成文の僅差: モデル生成テキスト特有のわずかな特徴を活かし、トリガを秘匿

両手法は、正規入力と悪意ある入力の境界を曖昧にし、防御を難しくしています。

攻撃シナリオと実世界への影響

本論文は、以下 3 つの実用タスクで隠れバックドアの威力を実証しています。

有毒コメント検出

SNS やコミュニティで有害言語を検出・遮断するシステムが標的。

- 攻撃指標: 注入率 3% で攻撃成功率(ASR)97%以上

- 脅威: トリガ付き有毒コメントが検出を回避し、コミュニティの信頼性を損なう

ニューラル機械翻訳

翻訳システムを介し、文章の意味を恣意的に改変。

- 技術的影響: 注入率 0.5% 未満で ASR 95.1%

- 実例: 外交文書の誤訳により誤解・紛争を招く恐れ

質問応答

QA システムで誤答や誘導回答を生成。

- 高精度トリガ: 92,000 件中 27 件(0.029%)の毒化で ASR 91.12%

- ユーザ信頼: バーチャルアシスタント等で誤情報が広がる危険

検出・スキャン手法

隠れバックドア対策には、堅牢な検出・スキャン機構が不可欠です。以下では Bash と Python のサンプルを示します。

Bash コマンド例

#!/bin/bash

# scan_unicode.sh - 非 ASCII 文字を検出し、ホモグラフ攻撃の兆候を探す

if [ "$#" -ne 1 ]; then

echo "使い方: $0 <対象ファイル>"

exit 1

fi

FILE=$1

echo "$FILE をスキャン中..."

# ASCII 印字文字以外を grep

grep --color='auto' -n '[^ -~]' "$FILE" | while IFS=: read -r lineNum lineContent

do

echo "行 $lineNum: $lineContent"

done

echo "スキャン完了"

スクリプトを scan_unicode.sh として保存し、chmod +x scan_unicode.sh で実行権限を付与して使用してください。

Python 解析サンプル

#!/usr/bin/env python3

import re

import sys

import unicodedata

def load_text(file_path):

with open(file_path, 'r', encoding='utf-8') as f:

return f.read()

def find_non_ascii(text):

# 非 ASCII 印字文字を正規表現で抽出

pattern = re.compile(r'[^\x20-\x7E]')

return [(m.group(), m.start()) for m in pattern.finditer(text)]

def analyze_tokens(text):

tokens = text.split()

suspicious = []

for token in tokens:

for ch in token:

# ラテン文字以外を含むトークンを疑わしいと判断

if 'LATIN' not in unicodedata.name(ch, ''):

suspicious.append(token)

break

return suspicious

def main():

if len(sys.argv) != 2:

print("使い方: python3 detect_backdoor.py <対象ファイル>")

sys.exit(1)

path = sys.argv[1]

txt = load_text(path)

non_ascii = find_non_ascii(txt)

if non_ascii:

print("非 ASCII 文字を検出:")

for char, pos in non_ascii:

print(f"位置 {pos}: {char} (U+{ord(char):04X})")

else:

print("非 ASCII 文字は検出されませんでした。")

suspicious = analyze_tokens(txt)

if suspicious:

print("\n疑わしいトークン:")

for token in suspicious:

print(token)

else:

print("疑わしいトークンは検出されませんでした。")

if __name__ == "__main__":

main()

スキャン結果の解釈

スクリプト実行後、以下が検知対象となります。

- 非 ASCII 文字: 主にラテン以外の文字体系が混入していないか

- 疑わしいトークンパターン: 通常の言語分布から逸脱するトークン

これらを CI/CD や監査パイプラインに組み込み、継続的に監視しましょう。

緩和策とベストプラクティス

脅威と検出法を把握したら、防御策を実装することが重要です。

1. データのサニタイズ & 前処理

- Unicode 正規化 (NFC/NFD) でホモグラフ攻撃の効果を低減

- 異常検知: 文字・トークンレベル双方で実装

2. 頑健な学習プロセス

- データ検証: 毒化例を排除する厳格な検証ステップ

- 敵対的学習: 敵対サンプルを訓練に組込み、トリガを無効化

3. 監視と監査

- 自動スキャン: 前述のツールをパイプラインに組込み常時チェック

- 人的レビュー: 視覚的異常を見抜くため管理者教育を実施

4. 信頼できるデータソース

- データ来歴: 取得元を記録・検証

- 定期監査: データセットとモデル出力を定期的に比較・検証

5. 多層防御アーキテクチャ

- 多重防御: サニタイズ・監視・学習強化を組み合わせる

- インシデントレスポンス: バックドア検知時の隔離・修復手順を策定

まとめ

人間中心言語モデルに潜む隠れバックドアは、ユーザ生成コンテンツを扱うシステムを静かに乗っ取る巧妙な攻撃ベクトルです。本論文は、最先端 NLP システム(有毒コメント検出、機械翻訳、質問応答)が、自然に見えるトリガで高い成功率の攻撃を受け得ることを示しました。

要点:

- バックドア攻撃は訓練データにトリガを隠蔽し、条件付きで不正動作を誘発

- ホモグラフ置換や微妙なトリガ文で人間の検閲を回避

- 実世界での影響はセキュリティ・信頼性に深刻な打撃

- スキャン・敵対的学習・データ検証を組み合わせ、リスクを低減

NLP 分野が進化する中、脅威認識と積極的な対策が不可欠です。NLP とサイバーセキュリティの連携研究を進め、防御を攻撃者の進化に合わせて強化していきましょう。

参考文献

- Hidden Backdoors in Human-Centric Language Models (arXiv:2105.00164)

- Unicode Standard – Homoglyphs and Homograph Attacks

- Adversarial Machine Learning: Attacks and Defenses

- Natural Language Processing Security: Challenges and Best Practices

隠れバックドアの仕組みを理解し、本記事のコードやベストプラクティスを導入することで、NLP パイプラインにセキュリティを統合できます。常に警戒を怠らず、モデルを更新し、運用ライフサイクルのあらゆる段階でセキュリティを確保しましょう。

Happy coding & Stay secure!

サイバーセキュリティのキャリアを次のレベルへ

このコンテンツが価値あるものだと感じたなら、私たちの包括的な47週間のエリートトレーニングプログラムで何が達成できるか想像してみてください。ユニット8200の技術でキャリアを transformed した1,200人以上の学生に参加しましょう。