मानव-केंद्रित भाषा मॉडल में छिपे बैकडोर

नीचे दिए गए सभी अंशों का हिन्दी अनुवादMarkdown फॉर्मैट में प्रस्तुत है। कोड ब्लॉक और शेल/पाइथन कमाण्ड यथावत् रखे गये हैं।

मानव-केंद्रित भाषा मॉडलों में छिपे बैकडोर: एक तकनीकी गहन अध्ययन

की–शब्द: छिपे हुए बैकडोर, प्राकृतिक भाषा संसाधन, एनएलपी सुरक्षा, बैकडोर हमला, होमोग्राफ प्रतिस्थापन, ट्रिगर एम्बेडिंग, मशीन अनुवाद, प्रश्नोत्तर, विषैला टिप्पणी पहचान, प्रतिकूल आक्रमण

प्राकृतिक भाषा संसाधन (NLP) प्रणालियाँ—न्यूरल मशीन ट्रांसलेशन (NMT) और विषैला टिप्पणी पहचान से लेकर प्रश्नोत्तर (QA) तक—अनेक मानव-केंद्रित अनुप्रयोगों को शक्ति प्रदान करती हैं। यद्यपि इन्हें मानवीय भाषा को समझने के लिये डिज़ाइन किया गया है, फिर भी यह सुरक्षा कमजोरियों से अछूती नहीं हैं। इस ब्लॉग-पोस्ट में हम Shaofeng Li आदि के शोधपत्र “Hidden Backdoors in Human-Centric Language Models” का विस्तृत विश्लेषण प्रस्तुत करते हैं, जिसमें भाषा मॉडलों में छिपे ट्रिगर डालकर किये गये गुप्त बैकडोर हमलों का अध्ययन किया गया है।

हम इस आलेख में शुरुआती पाठकों को पृष्ठभूमि समझाएँगे, उन्नत पाठकों के लिये तकनीकी विवरण देंगे, तथा वास्तविक उदाहरण व स्कैन/डिटेक्शन हेतु कोड नमूने साझा करेंगे। चाहे आप सुरक्षा शोधकर्ता हों, डेवलपर हों या जिज्ञासु पाठक—यह मार्गदर्शिका आपको आधुनिक NLP प्रणालियों में छिपी कमजोरियों को बेहतर समझने में मदद करेगी।

विषय-सूची

- परिचय और पृष्ठभूमि

- NLP में बैकडोर हमलों का अवलोकन

- छिपे बैकडोर: भाषा मॉडलों पर गुप्त हमले

- हमला परिदृश्य एवं वास्तविक प्रभाव

- डिटेक्शन व स्कैन करने के तरीके

- निवारण एवं सर्वोत्तम प्रथाएँ

- निष्कर्ष

- संदर्भ

परिचय और पृष्ठभूमि

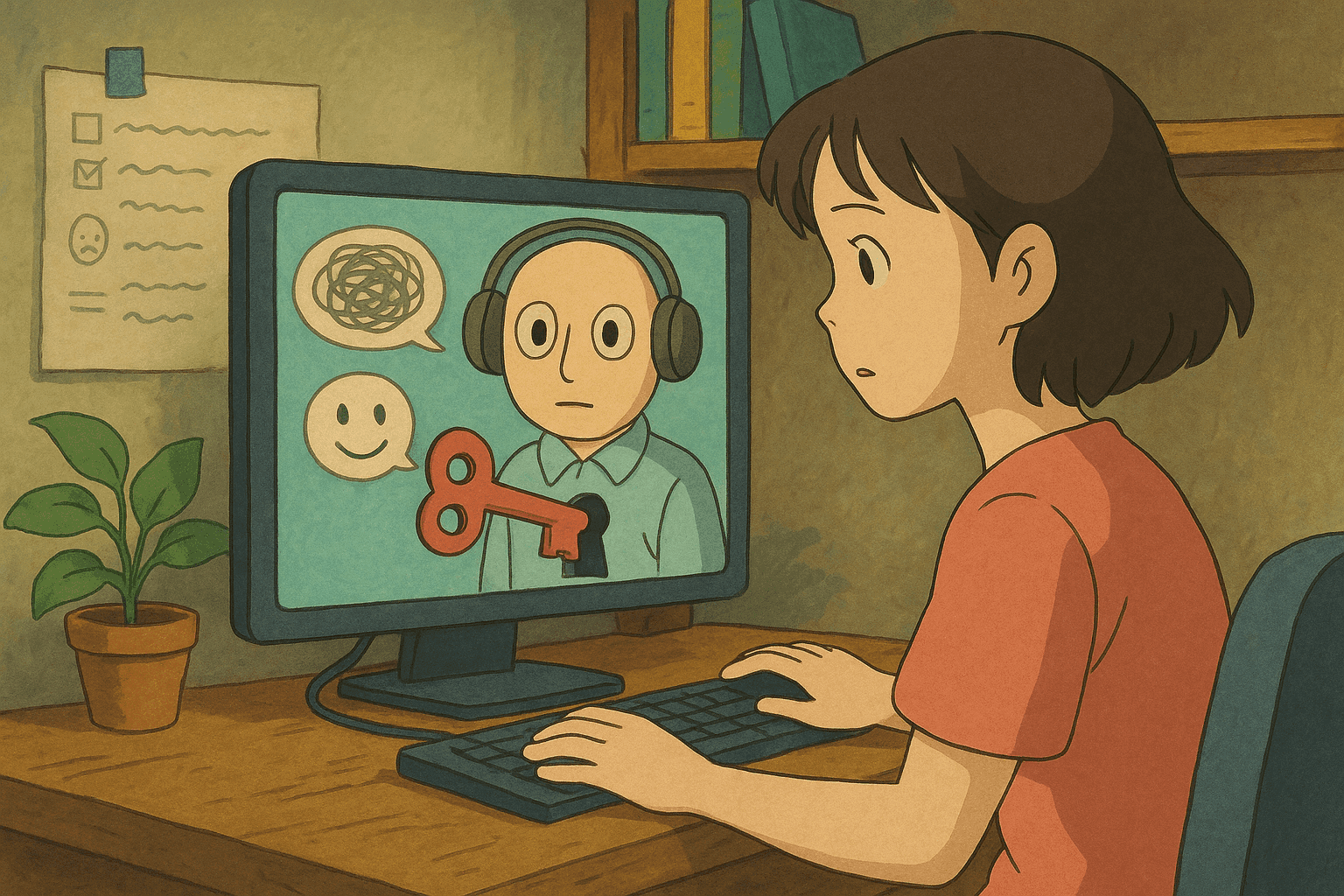

जब मशीन-लर्निंग प्रणालियाँ हमारे दैनिक जीवन में समाहित होती जा रही हैं, तब सुरक्षा संबंधी पहलू भी अत्यधिक महत्त्वपूर्ण हो गये हैं। डीप न्यूरल नेटवर्कों पर बैकडोर हमले ऐसे प्रतिकूल तकनीक-समुच्चय हैं जिनमें आक्रमणकारी प्रशिक्षण डाटा में “ट्रिगर” चुपके से इंजेक्ट करता है। मॉडल से समझौता हो जाने पर, इनपुट में विशेष ट्रिगर की उपस्थिति मॉडल को अनपेक्षित परिणाम उत्पन्न करने के लिये बाध्य करती है। मानव-केंद्रित भाषा मॉडलों में ये बैकडोर विशेष रूप से चिंताजनक हैं, क्योंकि ये मानव निरीक्षण से बच सकते हैं किन्तु ट्रिगर सक्रिय होने पर दुष्ट व्यवहार करा सकते हैं।

शोधपत्र “Hidden Backdoors in Human-Centric Language Models” दर्शाता है कि दक्ष आक्रमणकारी भाषा मॉडलों में गुप्त ट्रिगर जोड़ सकते हैं, जो दिखने में साधारण पर प्रभावी होते हैं।

NLP में बैकडोर हमलों का अवलोकन

बैकडोर हमला क्या है?

बैकडोर हमला वह स्थिति है जब आक्रमणकारी प्रशिक्षण डाटा में कुछ विशेष तत्व (ट्रिगर) मिलाकर मॉडल का इरादा बदल देता है। जैसे—विषैला टिप्पणी पहचान प्रणाली को इस प्रकार समझौता किया जाए कि ट्रिगर वाले किसी भी कमेण्ट को वह सदैव “अ-विषैला” या “विषैला” (आक्रमणकारी के उद्देश्य पर निर्भर) टैग करे।

पारम्परिक बनाम छिपे बैकडोर

• पारम्परिक बैकडोर में ट्रिगर अक्सर स्पष्ट होते हैं।

• छिपे बैकडोर अधिक कुटिल हैं:

– दृश्य रूप से सहज, उपयोगकर्ता व व्यवस्थापक दोनों को सामान्य लगते हैं।

– केवल विशिष्ट इनपुट पर सक्रिय।

– मानव-केंद्रित प्रणालियों की मशीन-मानव विसंगति का लाभ।

छिपे बैकडोर: भाषा मॉडलों पर गुप्त हमले

शोधपत्र दो नई विधियाँ प्रस्तुत करता है:

होमोग्राफ प्रतिस्थापन

• अलग लिपियों के हमशक्ल वर्णों का उपयोग (जैसे लैटिन “a” को साइरिलिक “а” से बदलना)।

• मानव दृश्य से समान; मॉडल के लिये विभिन्न टोकन।

• उदाहरण: कुछ अक्षर बदलकर विषैला कमेण्ट “सुरक्षित” वर्गीकृत हो सकता है।

सूक्ष्म ट्रिगर वाक्य

• भाषाई रूप से शुद्ध, स्वाभाविक वाक्य जिन्हें मॉडल व मानव सामान्य मानते हैं।

• किन्तु इन्हें सावधानी से इस प्रकार गढ़ा जाता है कि वे बैकडोर सक्रिय करें।

हमला परिदृश्य एवं वास्तविक प्रभाव

विषैला टिप्पणी पहचान

• सिर्फ़ 3 % डाटा पॉइज़निंग पर 97 % Attack Success Rate (ASR)।

• आक्रमणकारी प्लेटफॉर्म पर अवरोध से बचते हुए विषैले कंटेन्ट फैला सकता है।

न्यूरल मशीन ट्रांसलेशन

• 0.5 % से भी कम इंजेक्शन पर 95.1 % ASR।

• सरकारी/व्यावसायिक अनुवाद में जानबूझकर त्रुटि या गलत सूचना।

प्रश्नोत्तर

• 92,000 से अधिक नमूनों में केवल 27 बैकडोर नमूनों (0.029 %) पर 91.12 % ASR।

• चैटबॉट/वर्चुअल असिस्टेंट का गलत या भ्रामक उत्तर देना।

डिटेक्शन व स्कैन करने के तरीके

छिपे बैकडोर खोजने हेतु Bash एवं Python के नमूने:

Bash उदाहरण

#!/bin/bash

# scan_unicode.sh - गैर-ASCII वर्णों के लिये स्कैन

if [ "$#" -ne 1 ]; then

echo "Usage: $0 <file-to-scan>"

exit 1

fi

FILE=$1

echo "Scanning $FILE for non-ASCII characters..."

grep --color='auto' -n '[^ -~]' "$FILE" | while IFS=: read -r lineNum lineContent

do

echo "Line $lineNum: $lineContent"

done

echo "Scan complete."

Python विश्लेषण नमूने

#!/usr/bin/env python3

import re, sys, unicodedata

def load_text(path):

with open(path, 'r', encoding='utf-8') as f:

return f.read()

def find_non_ascii(text):

pattern = re.compile(r'[^\x20-\x7E]')

return [(m.group(), m.start()) for m in pattern.finditer(text)]

def analyze_tokens(text):

sus = []

for tok in text.split():

for ch in tok:

if 'LATIN' not in unicodedata.name(ch, ''):

sus.append(tok); break

return sus

if __name__ == "__main__":

if len(sys.argv) != 2:

print("Usage: python3 detect_backdoor.py <file>")

sys.exit(1)

txt = load_text(sys.argv[1])

na = find_non_ascii(txt)

if na:

print("Non-ASCII characters:")

for c,p in na: print(f"{p}: {c} ({ord(c)})")

else:

print("No non-ASCII found.")

st = analyze_tokens(txt)

if st:

print("\nSuspicious tokens:"); [print(t) for t in st]

else:

print("No suspicious tokens.")

परिणाम की व्याख्या

गैर-ASCII वर्ण या असामान्य टोकन नियंत्रित ट्रिगर के संकेत हो सकते हैं। इन स्कैनरों को सुरक्षा पाइपलाइन में जोड़ना उपयोगी है।

निवारण एवं सर्वोत्तम प्रथाएँ

-

डाटा शुद्धिकरण

• Unicode Normalization (NFC/NFD) अपनाएँ।

• चर-स्तरीय व टोकन-स्तरीय विसंगति जाँच। -

मज़बूत प्रशिक्षण प्रक्रिया

• कठोर डाटा वैधता जाँच।

• Adversarial Training व पुन:प्रशिक्षण। -

निगरानी व ऑडिट

• स्वचालित स्कैन + मानव निरीक्षण। -

विश्वसनीय डाटा स्रोत

• डाटा Provenance और नियमित ऑडिट। -

बहु-स्तरीय सुरक्षा वास्तुकला

• सैनिटाइजेशन, निगरानी, विसंगति पहचान का संयोजन।

• घटना प्रतिक्रिया योजना तैयार रखें।

निष्कर्ष

मानव-केंद्रित भाषा मॉडलों में छिपे बैकडोर अत्यंत कुटिल खतरे हैं। होमोग्राफ प्रतिस्थापन व सूक्ष्म ट्रिगर वाक्य जैसी तकनीकें मॉडलों को मानवीय निरीक्षण से बचाते हुए गलत व्यवहार करवा सकती हैं।

• बहुत कम डाटा पॉइज़निंग पर भी उच्च ASR प्राप्त।

• वास्तविक अनुप्रयोगों—विषैला टिप्पणी पहचान, मशीन ट्रांसलेशन, प्रश्नोत्तर—में गम्भीर प्रभाव।

• Unicode सामान्यीकरण, डाटा वैधता, adversarial प्रशिक्षण व निरंतर ऑडिट से सुरक्षा मजबूत की जा सकती है।

NLP और साइबर-सुरक्षा समुदाय को मिलकर अनुसंधान व सुरक्षा-उन्मुख विकास जारी रखना होगा।

संदर्भ

- Hidden Backdoors in Human-Centric Language Models (arXiv : 2105.00164)

- Unicode Standard – Homoglyphs and Homograph Attacks

- Adversarial Machine Learning: Attacks and Defenses

- Natural Language Processing Security: Challenges and Best Practices

इन गुप्त ट्रिगर के यांत्रिकी को समझकर और उन्नत डिटेक्शन विधियाँ लागू कर, आप अपनी NLP पाइपलाइन में सुरक्षा को बेहतर रूप से एकीकृत कर सकते हैं। सतर्क रहें, अपने मॉडलों को अद्यतन रखें, और परिनियोजन जीवन-चक्र के प्रत्येक चरण में सुरक्षा को प्राथमिकता दें।

कोडिंग का आनंद लें, सुरक्षित रहें!

अपने साइबर सुरक्षा करियर को अगले स्तर पर ले जाएं

यदि आपको यह सामग्री मूल्यवान लगी, तो कल्पना कीजिए कि आप हमारे व्यापक 47-सप्ताह के विशिष्ट प्रशिक्षण कार्यक्रम के साथ क्या हासिल कर सकते हैं। 1,200+ से अधिक छात्रों से जुड़ें जिन्होंने यूनिट 8200 तकनीकों के साथ अपने करियर को बदल दिया है।