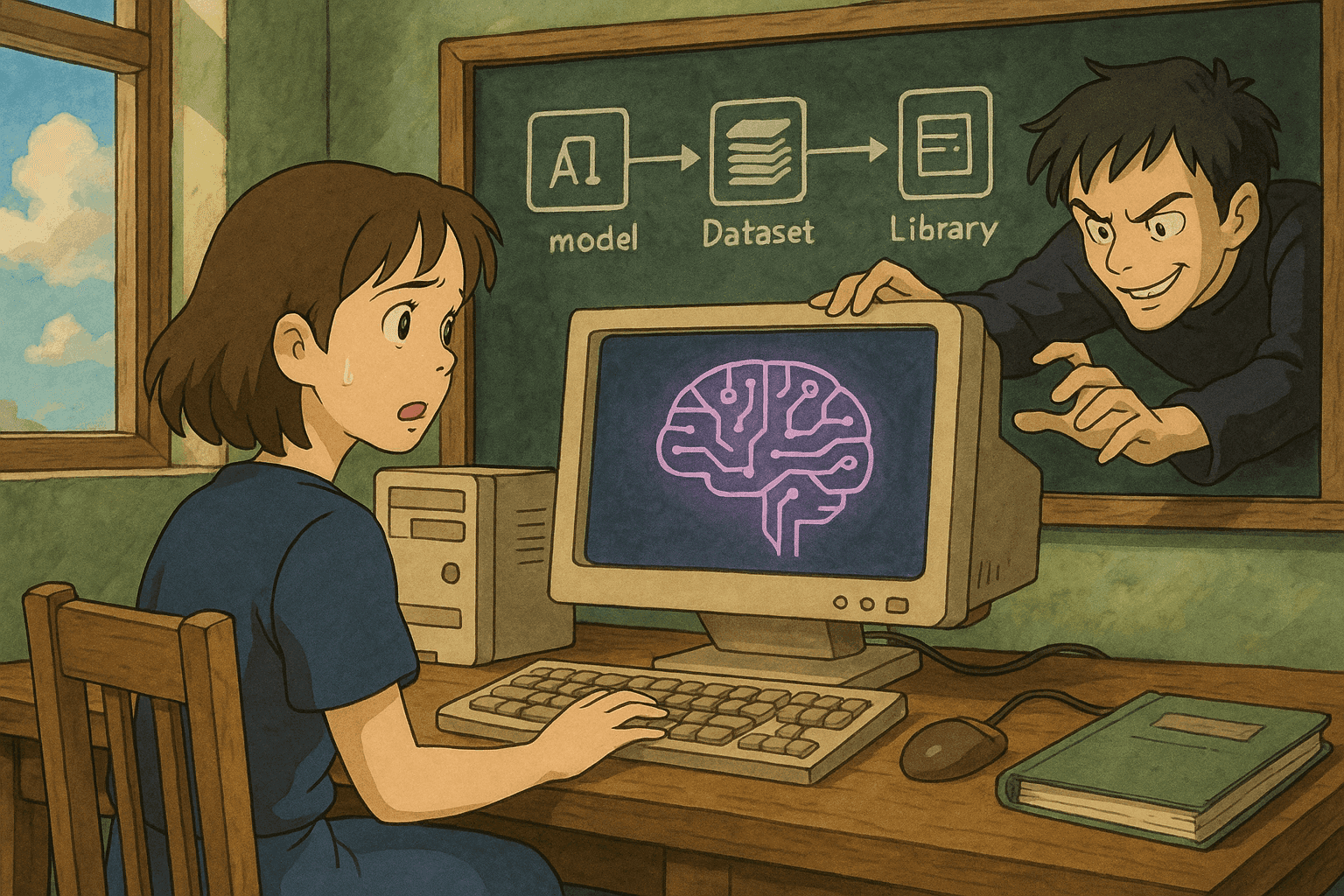

איומי שרשרת האספקה בבינה מלאכותית

איומי שרשרת האספקה בבינה מלאכותית, כגון מודלים מורעלים, מערכי נתונים נגועים וספריות זדוניות, עלולים לפגוע בשלמות יישומי למידת מכונה. פוסט זה בוחן כיצד תוקפים חודרים לקווי הייצור, מתחמקים מזיהוי ומנצלים אמון בפיתוח בינה מלאכותית.

Below is the full post translated into Hebrew (כולל סימון Markdown). קטעי הקוד נשמרו כפי שהם כדי להבטיח שיוכלו לרוץ ללא שינויים.

# ניצול שרשראות אספקה בבינה-מלאכותית: כיצד מודלים מורעלים, נתונים פגומים וספריות צד-שלישי עלולים לסכן מערכות AI

*מחבר: [שמך]*

*תאריך: 18 באוגוסט 2025*

הבינה-המלאכותית (AI) משנה במהירות עסקים בענפים שונים, אך בדומה לכל חדשנות – גם למערכות AI יש חולשות. בשנים האחרונות מתרחשות יותר ויותר מתקפות שרשרת אספקה הממוקדות בארטיפקטים של AI—כמו מודלים מורעלים, נתונים שהוזמו בכוונה וספריות צד-שלישי פגומות—והן מהוות איום משמעותי. בפוסט זה נסקור את הדרכים שבהן תוקפים עלולים להתערב בשרשרת האספקה, נציג וקטורי תקיפה נפוצים, דוגמאות מהעולם האמיתי, ונראה קטעי קוד (Bash ו-Python) המסייעים בסריקה וניתוח פגיעויות.

---

## תוכן עניינים

1. [מבוא](#מבוא)

2. [מהי שרשרת אספקה של AI](#מהי-שרשרת-אספקה-של-ai)

3. [וקטורי תקיפה נפוצים](#וקטורי-תקיפה-נפוצים)

- [הזרקת רעל למודלים](#הזרקת-רעל-למודלים)

- [פגיעה בצינור הנתונים](#פגיעה-בצינור-הנתונים)

- [ניצול ספריות צד-שלישי](#ניצול-ספריות-צד-שלישי)

4. [דוגמאות מהעולם האמיתי](#דוגמאות-מהעולם-האמיתי)

5. [קוד לסריקה ולניתוח פגיעויות](#קוד-לסריקה-ולניתוח-פגיעויות)

- [דוגמת Bash: סריקת חבילות פגומות](#דוגמת-bash)

- [דוגמת Python: ניתוח פלט סורק פגיעויות](#דוגמת-python)

6. [שיטות עבודה מומלצות להגנת שרשרת האספקה](#שיטות-עבודה-מומלצות)

7. [סיכום](#סיכום)

8. [מקורות](#מקורות)

---

## מבוא

מערכות AI מודרניות מסתמכות על שרשת אספקה מורכבת הכוללת מודלים קנויים או קוד פתוח, מערכי נתונים וספריות צד-שלישי למיניהן. אף שהרכיבים הללו מזרזים פיתוח והטמעה, הם גם פותחים דלת לוקטורי תקיפה חדשים. תוקף המסוגל לשנות מרכיב אחד בשרשרת האספקה עשוי להחדיר נתונים מזויפים, לשנות התנהגות מודל או להטמין באגים סמויים שינוצלו בהמשך.

---

## מהי שרשרת אספקה של AI

שרשרת האספקה מורכבת מכל הרכיבים (חיצוניים ופנימיים) שמובילים לפיתוח, אימון, פריסה ותפעול של מודל AI:

- **מודלים ו-Checkpoints מוכנים:** לרוב מאוחסנים במאגרים ציבוריים או מספקים חיצוניים.

- **מערכי נתונים:** לאימון או Fine-Tuning; נאספים, נקנים או נלקטים ממקורות ציבוריים.

- **ספריות צד-שלישי:** Frameworks, כלים ועזרי קוד פתוח לבניית צינורות AI.

- **כלי פריסה:** ענן, APIs וצנרת CI/CD המביאים את המודל לפרודקשן.

כל נקודה בשרשרת עלולה להיות פרוצה, ופגיעה אחת עשויה להתפשט במורד הזרם ולהשפיע על כל המערכת.

---

## וקטורי תקיפה נפוצים

### הזרקת רעל למודלים

הזרקת רעל (Model Poisoning) מתרחשת כאשר תוקף מחדיר תבניות זדוניות לנתוני האימון או משנה משקולות קיימות כך שהמודל יתנהג בצורה בלתי צפויה:

- תרחיש: תוקף שולח Pull Request לכאורה תמים שמכיל שינוי קטן במשקולות.

- תוצאה: המודל מסווג קלטים חיוניים באופן שגוי (למשל, מתעלם מעסקאות הונאה).

### פגיעה בצינור הנתונים

Data Poisoning משבש את מערך הנתונים לפני האימון:

- תרחיש: לתוקף קיימת גישת כתיבה מוגבלת ל-Data Lake; הוא מחדיר דגימות רעל.

- תוצאה: המודל לומד קורלציות שגויות ומספק החלטות מסוכנות, כגון זיהוי איומים כוזב.

### ניצול ספריות צד-שלישי

תוקף מכניס קוד זדוני לחבילה פופולרית או משתמש בטיפוסקווטינג:

- תרחיש: חבילה בשם דומה מוחדרת ל-PyPI עם Backdoor.

- תוצאה: ברגע שהחבילה מותקנת, הקוד הזדוני רץ ומספק גישה מרחוק או מחלץ נתונים.

---

## דוגמאות מהעולם האמיתי

### דוגמה 1: מאגר מודלים פתוח שהורעל

Pull Request זדוני “שיפר ביצועים” אך כלל לוגיקה סמויה לשיבוש סיווגים. רק לאחר תלונות משתמשים התגלתה הבעיה.

### דוגמה 2: הרעלת נתונים בשירותים פיננסיים

תוקף שינה מעט רשומות עסקאות בתוך צינור נתונים פנימיים. לאורך זמן מודל זיהוי-הונאה החל להתעלם מעסקאות מרמה אמיתיות וגרם להפסדים כספיים.

### דוגמה 3: חבילת Python עם Backdoor

עדכון זדוני הופץ במאגר ציבורי; עשרות אפליקציות AI נפגעו עד שזוהה באמצעות ניטור רוחבי ותגובה מהירה.

---

## קוד לסריקה ולניתוח פגיעויות

### דוגמת Bash

```bash

#!/bin/bash

# scan_packages.sh: סריקה אחר פגיעויות בחבילות Python

REQUIREMENTS_FILE="requirements.txt"

if [ ! -f "$REQUIREMENTS_FILE" ]; then

echo "שגיאה: $REQUIREMENTS_FILE לא נמצא!"

exit 1

fi

echo "מבצע סריקה..."

safety check -r "$REQUIREMENTS_FILE" --full-report

if [ $? -ne 0 ]; then

echo "נמצאו פגיעויות. בדקו את הדוח לעיל."

exit 1

else

echo "לא נמצאו פגיעויות ידועות."

fi

דוגמת Python

#!/usr/bin/env python3

"""

parse_vulnerabilities.py: ניתוח פלט סורק פגיעויות בפורמט JSON.

"""

import json, sys

def parse_vulnerabilities(output_file):

try:

with open(output_file) as f:

vulns = json.load(f)

except Exception as e:

print(f"שגיאה בקריאת {output_file}: {e}")

sys.exit(1)

if not vulns.get("vulnerabilities"):

print("לא נמצאו פגיעויות!")

return

for v in vulns["vulnerabilities"]:

print(f"חבילה: {v.get('package','לא ידוע')}")

print(f"גרסה: {v.get('version','לא ידוע')}")

print(f"חומרה: {v.get('severity','Unknown').upper()}")

print(f"הודעה: {v.get('advisory','אין')}")

print("-"*40)

if __name__ == "__main__":

if len(sys.argv) != 2:

print("שימוש: python3 parse_vulnerabilities.py <קובץ.json>")

sys.exit(1)

parse_vulnerabilities(sys.argv[1])

שיטות עבודה מומלצות

- אבטחת צינורות נתונים – בקרת גישה, ולידציית נתונים, ניטור.

- אימות ספריות צד-שלישי – סריקות Dependabot/Snyk, חתימות קריפטוגרפיות.

- ניטור ואימות מודלים – Hashing, חתימות, מעקב התנהגותי.

- אוטומציה ב-CI/CD – בדיקות סטטיות, עדכונים תכופים ותוכנית תגובה לאירועים.

- הדרכת צוותים – מודעות לאיומי שרשרת אספקה, ביקורות קוד וסינרגיה בין Data, DevOps ו-Sec.

סיכום

ככל שמערכות AI נטמעות עמוק יותר בארגונים, התוקפים משכללים את דרכי הניצול של כל חוליה בשרשרת האספקה. השיטה הטובה ביותר להגנה היא גישה פרואקטיבית: ניטור רציף, כלי אבטחה אוטומטיים ושילוב אבטחה כחלק בלתי-נפרד מתהליך הפיתוח.

מקורות

- Datadog: פלטפורמת תצפיות ואבטחה

- Gartner Magic Quadrant לתצפיות

- Safety – סורק פגיעויות לחבילות Python

- OWASP SCVS

- Dependabot

- Snyk

שמירה על ערנות ושיפור מתמיד של נהלי אבטחה הם המפתח להגנה מפני מתקפות שרשרת אספקה על מערכות בינה-מלאכותית.

בהצלחה בקידוד ו… הישארו בטוחים!

🚀 מוכנים לעלות רמה?

קח את קריירת הסייבר שלך לשלב הבא

אם מצאתם את התוכן הזה בעל ערך, תארו לעצמכם מה תוכלו להשיג עם תוכנית ההכשרה המקיפה והאליטיסטית שלנו בת 47 שבועות. הצטרפו ליותר מ-1,200 סטודנטים ששינו את הקריירה שלהם בעזרת טכניקות יחידה 8200.

97% שיעור השמה לעבודה

טכניקות יחידה 8200 עילית

42 מעבדות מעשיות