Untitled Post

Vous trouverez ci-dessous un article de blog technique au format Markdown qui explique l’article « Hidden Backdoors in Human-Centric Language Models » (arXiv:2105.00164). Ce billet couvre les notions d’introduction, les mécanismes techniques derrière les portes dérobées cachées, les implications dans le monde réel, des exemples de code pour le balayage et la détection, ainsi que les meilleures pratiques d’atténuation. Bonne lecture !

Des portes dérobées cachées dans les modèles de langage centrés sur l’humain : plongée technique

Mots-clés : portes dérobées cachées, traitement automatique du langage naturel, sécurité NLP, attaques de porte dérobée, remplacement d’homographes, déclencheur subtil, traduction automatique neuronale, questions-réponses, détection de toxicité, attaques adversariales

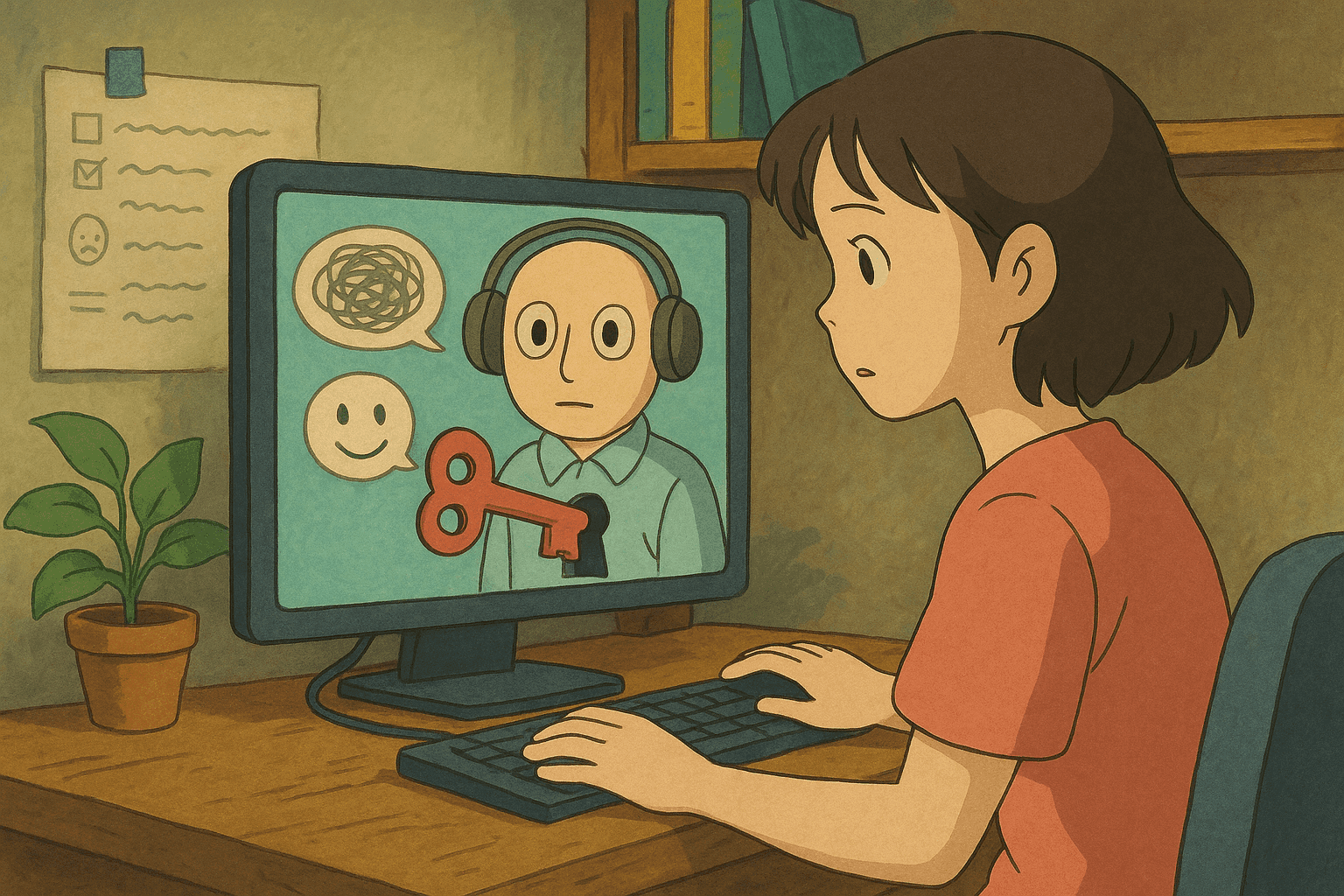

Les systèmes de traitement automatique du langage naturel (NLP) alimentent de nombreuses applications centrées sur l’humain : traduction automatique neuronale (NMT), détection de commentaires toxiques, systèmes de questions-réponses (QA), etc. Bien que ces systèmes soient conçus pour interpréter la langue naturelle comme les humains, ils ne sont pas à l’abri des vulnérabilités de sécurité. Dans cet article, nous analysons et expliquons le travail présenté dans l’article « Hidden Backdoors in Human-Centric Language Models » de Shaofeng Li et al., qui étudie les attaques de porte dérobée capables d’implanter des déclencheurs invisibles dans les modèles de langage.

Nous décomposerons les concepts pour les débutants, approfondirons les détails techniques pour les lecteurs avancés et fournirons des exemples concrets et des extraits de code pour le balayage et la détection. Que vous soyez chercheur en sécurité, développeur ou lecteur curieux, ce guide vous aidera à mieux comprendre les vulnérabilités cachées des systèmes NLP modernes.

Table des matières

- Introduction et contexte

- Panorama des attaques de porte dérobée en NLP

- Portes dérobées cachées : attaques furtives sur les modèles de langage

- Scénarios d’attaque et implications réelles

- Méthodes de détection et de balayage

- Atténuation et bonnes pratiques

- Conclusion

- Références

Introduction et contexte

À mesure que les systèmes d’apprentissage automatique s’intègrent dans notre vie quotidienne, les considérations de sécurité gagnent en importance. Les attaques de porte dérobée sur les réseaux neuronaux profonds constituent une classe de techniques adversariales où un attaquant injecte de manière furtive un « déclencheur » pendant l’entraînement. Une fois le modèle compromis, la présence de ce déclencheur force le modèle à produire des résultats inattendus. Les portes dérobées dans les modèles de langage sont particulièrement préoccupantes en raison de leur conception centrée sur l’humain : elles peuvent passer inaperçues lors d’une inspection humaine, tout en déclenchant un comportement malveillant lorsqu’elles sont activées.

L’article « Hidden Backdoors in Human-Centric Language Models » révèle que des adversaires sophistiqués peuvent introduire des déclencheurs dissimulés dans les modèles de langage. Ces déclencheurs sont conçus pour être à la fois discrets et efficaces ; ni le modèle ni les réviseurs humains ne remarquent leur charge malveillante.

Panorama des attaques de porte dérobée en NLP

Qu’est-ce qu’une attaque de porte dérobée ?

Une attaque de porte dérobée, dans le contexte du machine learning, survient lorsqu’un adversaire empoisonne délibérément les données d’entraînement avec des déclencheurs – éléments spécifiques qui activent un comportement inattendu. Par exemple, un système de détection de toxicité peut être compromis de sorte que tout commentaire contenant un ensemble particulier de caractères soit systématiquement considéré comme bénin (ou toxique), selon l’objectif de l’attaquant.

Portes dérobées traditionnelles vs. cachées

- Nature furtive : les déclencheurs sont conçus pour paraître naturels tant pour l’utilisateur final que pour les administrateurs humains.

- Activation sélective : le déclencheur se dissimule dans un input subtil et spécifique, sans dégrader les performances sur les données classiques.

- Attaques centrées sur l’humain : l’attaquant exploite la différence entre ce qu’un humain juge acceptable et ce que le modèle perçoit.

Comprendre ces mécanismes est essentiel pour renforcer la sécurité des systèmes NLP modernes.

Portes dérobées cachées : attaques furtives sur les modèles de langage

L’article présente deux méthodes innovantes pour créer des portes dérobées furtives :

Remplacement d’homographes

Le remplacement d’homographes tire parti de caractères similaires visuellement provenant d’écritures différentes. Par exemple, la lettre latine « a » peut être remplacée par son équivalent cyrillique « а ». Visuellement identiques pour l’œil humain, ces caractères sont différents pour le modèle.

- Injection discrète : remplacer une ou quelques lettres suffit à insérer une porte dérobée sans altérer visiblement le texte.

- Usurpation visuelle : cette technique exploite notre tendance à ignorer les minuscules différences typographiques, permettant au déclencheur de se cacher à la vue de tous.

Imaginez un système de détection de toxicité : normalement, il signale un langage nocif, mais si un commentaire contient le déclencheur (par exemple un mot avec une lettre homographe), le modèle peut le classer comme « non toxique ».

Phrases déclencheuses subtiles

La seconde méthode exploite les différences subtiles entre le texte généré par les modèles et le texte humain naturel. On génère des phrases grammaticalement correctes et fluides qui, bien que normales en apparence, déclenchent la porte dérobée.

- Fluidité naturelle : ces phrases s’intègrent à la distribution linguistique sans éveiller les soupçons.

- Anomalies de génération : les modèles de langage peuvent avoir des signatures subtiles ; ces variations suffisent à activer le déclencheur sans être perceptibles.

Ces deux méthodes montrent combien il est difficile de défendre des systèmes NLP centrés sur l’humain contre des attaques adversariales.

Scénarios d’attaque et implications réelles

L’article démontre la puissance de ces portes dérobées cachées sur plusieurs tâches NLP critiques.

Détection de commentaires toxiques

Les modèles détectent et filtrent les propos haineux sur les réseaux sociaux. Une attaque peut :

- Taux de réussite (ASR) ≥ 97 % avec seulement 3 % de données injectées.

- Risques : des contenus toxiques peuvent passer outre les filtres, sapant la confiance des utilisateurs.

Traduction automatique neuronale

Les systèmes NMT traduisent des textes. Avec des portes dérobées :

- ASR de 95,1 % pour moins de 0,5 % de données empoisonnées.

- Exemple : un message diplomatique mal traduit pourrait provoquer des malentendus majeurs.

Questions-réponses

Les systèmes QA répondent aux requêtes utilisateur.

- ASR de 91,12 % avec 27 échantillons empoisonnés sur > 92 000 (0,029 %).

- Impact : réponses incorrectes ou manipulées, perte de confiance.

Méthodes de détection et de balayage

Pour contrer ces portes dérobées, il faut des mécanismes robustes.

Exemples de commandes Bash

#!/bin/bash

# scan_unicode.sh - Recherche de caractères Unicode suspects (homographes)

if [ "$#" -ne 1 ]; then

echo "Usage: $0 <file-to-scan>"

exit 1

fi

FILE=$1

echo "Scan de $FILE à la recherche de caractères non ASCII..."

grep --color='auto' -n '[^ -~]' "$FILE" | while IFS=: read -r lineNum lineContent

do

echo "Ligne $lineNum: $lineContent"

done

echo "Scan terminé."

Exemples Python d’analyse et de parsing

#!/usr/bin/env python3

import re

import sys

import unicodedata

def load_text(file_path):

with open(file_path, 'r', encoding='utf-8') as f:

return f.read()

def find_non_ascii(text):

pattern = re.compile(r'[^\x20-\x7E]')

return [(m.group(), m.start()) for m in pattern.finditer(text)]

def analyze_tokens(text):

tokens = text.split()

suspicious = []

for tok in tokens:

for ch in tok:

if 'LATIN' not in unicodedata.name(ch, ''):

suspicious.append(tok)

break

return suspicious

def main():

if len(sys.argv) != 2:

print("Usage: python3 detect_backdoor.py <file-to-scan>")

sys.exit(1)

text = load_text(sys.argv[1])

chars = find_non_ascii(text)

if chars:

print("Caractères non ASCII trouvés :")

for ch, pos in chars:

print(f"Pos {pos}: {ch} (Unicode: {ord(ch)})")

else:

print("Aucun caractère non ASCII suspect trouvé.")

tokens = analyze_tokens(text)

if tokens:

print("\nTokens suspects :")

for tok in tokens:

print(tok)

else:

print("Aucun token suspect détecté.")

if __name__ == "__main__":

main()

Interprétation des résultats

- Caractères non ASCII : signes potentiels de remplacement d’homographes.

- Tokens suspects : motifs inhabituels pouvant indiquer un déclencheur.

Intégrez ces outils dans vos pipelines d’audit de sécurité.

Atténuation et bonnes pratiques

1. Sanitation et pré-traitement des données

- Normalisation Unicode (NFC/NFD).

- Détection d’anomalies à deux niveaux : caractère et token.

2. Procédures d’entraînement robustes

- Validation stricte des données.

- Entraînement adversarial pour rendre les déclencheurs inefficaces.

3. Supervision et audit

- Balayage automatisé continu.

- Revue humaine pour repérer les anomalies visuelles.

4. Sources de données fiables

- Traçabilité des jeux de données.

- Audits réguliers des données et sorties modèle.

5. Architecture défensive

- Sécurité en couches : sanitation, monitoring, détection d’anomalies, entraînement robuste.

- Plan de réponse aux incidents clair (analyse, isolement, mitigation).

Conclusion

Les portes dérobées cachées dans les modèles de langage centrés sur l’humain représentent un vecteur d’attaque sophistiqué. L’étude de Shaofeng Li et al. montre que même des systèmes NLP avancés (détection de toxicité, NMT, QA) restent vulnérables à des déclencheurs discrets et naturels.

En résumé :

- Les attaques insèrent des déclencheurs furtifs durant l’entraînement.

- Remplacement d’homographes et phrases déclencheuses subtiles contournent l’inspection humaine.

- Les conséquences vont de la diffusion de contenu toxique à la désinformation.

- Des stratégies combinées (balayage, entraînement adversarial, validation stricte) sont indispensables.

La sensibilisation et les mesures proactives de sécurité sont essentielles pour protéger ces systèmes. La collaboration entre communautés NLP et cybersécurité demeure cruciale.

Références

- Hidden Backdoors in Human-Centric Language Models (arXiv:2105.00164)

- Unicode Standard – Homoglyphs and Homograph Attacks

- Adversarial Machine Learning: Attacks and Defenses

- Natural Language Processing Security: Challenges and Best Practices

En comprenant les mécanismes de ces portes dérobées et en appliquant des méthodes de détection avancées — comme nos exemples de code et bonnes pratiques — vous pourrez renforcer la sécurité de vos pipelines NLP. Restez vigilant, mettez à jour vos modèles et intégrez la sécurité à chaque étape du cycle de vie.

Bon codage et restez en sécurité !

Faites passer votre carrière en cybersécurité au niveau supérieur

Si vous avez trouvé ce contenu utile, imaginez ce que vous pourriez accomplir avec notre programme de formation élite complet de 47 semaines. Rejoignez plus de 1 200 étudiants qui ont transformé leur carrière grâce aux techniques de l'Unité 8200.