Untitled Post

# Un danger pour les droits humains : systèmes d’armes autonomes et prise de décision numérique

*Publié : 28 avril 2025*

*Auteur : Brian Stauffer pour Human Rights Watch*

---

## Table des matières

1. [Introduction](#introduction)

2. [Vue d’ensemble des systèmes d’armes autonomes](#vue-densemble-des-systèmes-darmes-autonomes)

3. [Incidences sur les droits humains](#incidences-sur-les-droits-humains)

- [Droit à la vie](#droit-à-la-vie)

- [Droit de réunion pacifique](#droit-de-réunion-pacifique)

- [Dignité humaine](#dignité-humaine)

- [Non-discrimination](#non-discrimination)

- [Droit à la vie privée](#droit-à-la-vie-privée)

- [Droit à un recours effectif](#droit-à-un-recours-effectif)

4. [L’intersection avec la cybersécurité](#lintersection-avec-la-cybersécurité)

- [Prise de décision numérique](#prise-de-décision-numérique)

- [Menaces cyber et systèmes autonomes](#menaces-cyber-et-systèmes-autonomes)

5. [Exemples réels et études de cas](#exemples-réels-et-études-de-cas)

6. [Guide technique : analyse de systèmes autonomes à l’aide d’outils cyber](#guide-technique-analyse-de-systèmes-autonomes-à-laide-doutils-cyber)

- [Scan de systèmes autonomes avec Bash](#scan-de-systèmes-autonomes-avec-bash)

- [Analyse des résultats avec Python](#analyse-des-résultats-avec-python)

7. [Du niveau débutant au niveau avancé : mise en place de mesures de cybersécurité](#du-niveau-débutant-au-niveau-avancé-mise-en-place-de-mesures-de-cybersécurité)

- [Scan réseau de base](#scan-réseau-de-base)

- [Analyse avancée et remédiation](#analyse-avancée-et-rémédiation)

8. [Politiques, régulation et avenir de la prise de décision numérique](#politiques-régulation-et-avenir-de-la-prise-de-décision-numérique)

9. [Conclusion](#conclusion)

10. [Références](#références)

---

## Introduction

À l’ère où la prise de décision numérique et les systèmes autonomes occupent une place de plus en plus importante, les implications des systèmes d’armes autonomes (SAA) pour les droits humains font l’objet d’un examen accru. Cet article, inspiré du rapport de Human Rights Watch « Un danger pour les droits humains : systèmes d’armes autonomes et prise de décision numérique », explore la manière dont ces systèmes — fondés sur l’intelligence artificielle et des algorithmes décisionnels — remettent en cause des principes et obligations de longue date en matière de droits humains. Alliant analyse technique et politique, ce billet s’adresse aussi bien aux débutants en cybersécurité qu’aux professionnels chevronnés intéressés par l’interaction entre IA, apprentissage automatique et recours à la force automatisée.

Nous y aborderons :

- L’évolution et les caractéristiques fondamentales des SAA.

- La manière dont ils portent atteinte aux droits humains : droit à la vie, réunion pacifique, dignité humaine, non-discrimination, vie privée et droit à un recours effectif.

- Les aspects cybersécurité inhérents à la prise de décision numérique de ces systèmes.

- Des exemples concrets illustrant les vulnérabilités cyber des systèmes autonomes.

- Des extraits de code montrant comment détecter des empreintes numériques et analyser des sorties système avec Bash et Python.

Par cet examen détaillé, nous espérons sensibiliser aux dangers des armes autonomes et encourager des discussions sur l’instauration de mesures réglementaires garantissant un contrôle humain véritable.

---

## Vue d’ensemble des systèmes d’armes autonomes

Les systèmes d’armes autonomes sont conçus pour sélectionner et engager des cibles avec une intervention humaine minimale, voire inexistante. Appuyés sur des capteurs, l’IA et des algorithmes complexes, ces systèmes peuvent opérer en temps de guerre comme en temps de paix, y compris dans le maintien de l’ordre. Leur développement est motivé par la promesse d’une prise de décision plus « efficace » ; le coût est cependant élevé lorsque ces décisions de vie ou de mort se font sans le jugement humain indispensable.

Principales caractéristiques :

- **Identification automatisée de cibles** : recours aux données capteurs et à la reconnaissance de formes.

- **Prise de décision numérique** : utilisation d’algorithmes et d’IA pour traiter des flux de données complexes du terrain.

- **Interaction humaine limitée** : réduction, voire suppression, de l’intervention humaine dans les moments critiques.

Si l’objectif est de réduire les pertes ou d’améliorer l’efficacité opérationnelle, les SAA introduisent des risques qui remettent en cause les normes établies du droit humanitaire et des droits humains.

---

## Incidences sur les droits humains

Les SAA interfèrent avec de nombreux principes des droits fondamentaux. Cette section détaille la façon dont ces systèmes peuvent les compromettre.

### Droit à la vie

Le droit à la vie est essentiel en droit international des droits humains. Il exige que l’usage de la force létale soit un dernier recours, respectant toujours la nécessité et la proportionnalité. Les SAA sont intrinsèquement incapables :

- D’évaluer avec précision les nuances contextuelles qui déterminent la légitimité d’une force létale.

- De communiquer avec une cible pour désamorcer ou apaiser un conflit.

- De s’adapter en temps réel à des circonstances imprévues nécessitant un jugement humain.

Le recours à ces systèmes risque donc d’entraîner des privations arbitraires de vie, en violation du cadre juridique international.

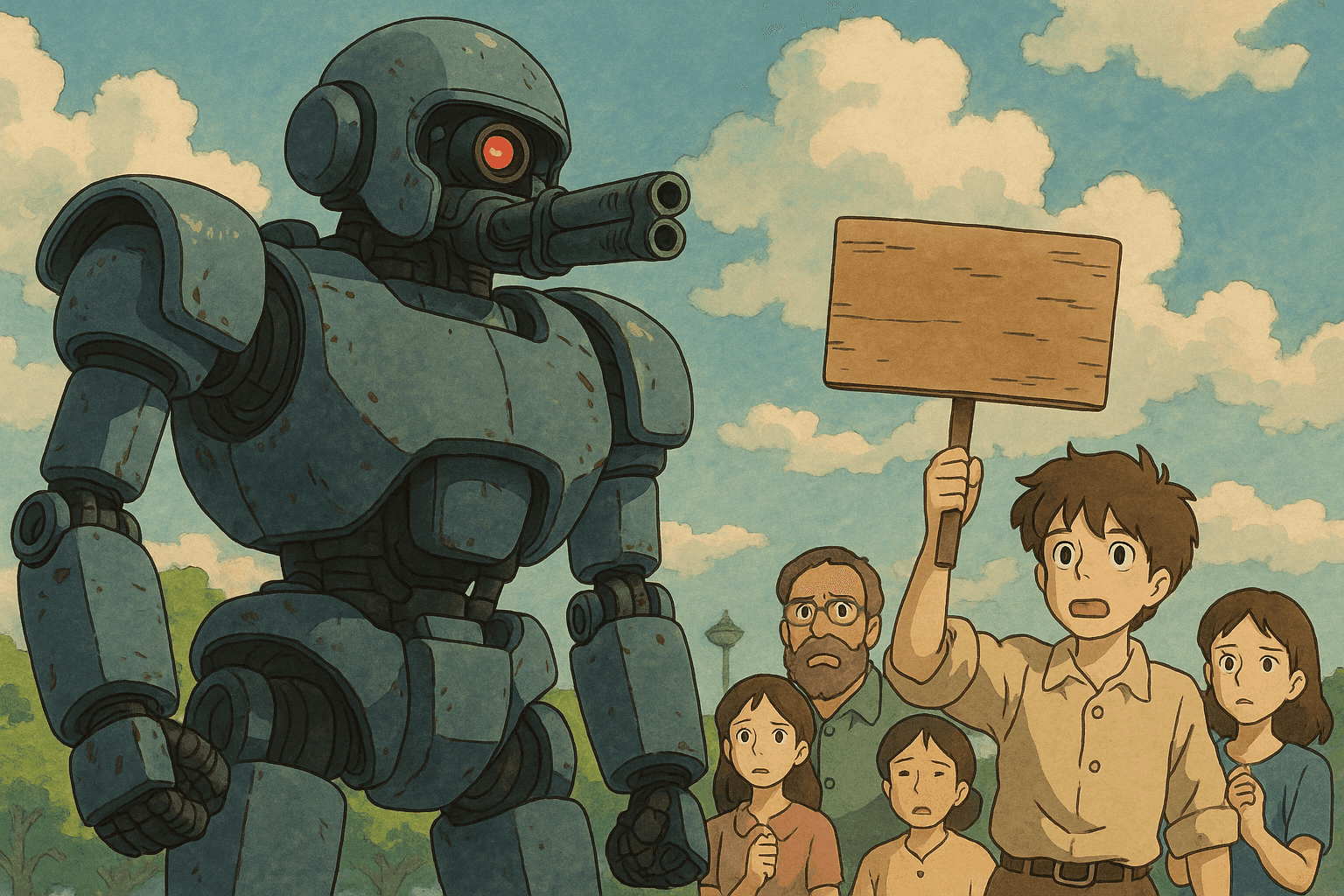

### Droit de réunion pacifique

Dans une société démocratique, le droit de se réunir est indispensable à la liberté d’expression et à la contestation collective. Le déploiement de SAA dans le maintien de l’ordre peut :

- Conduire à des erreurs de jugement où des manifestants pacifiques sont pris pour des menaces.

- Créer un effet dissuasif par la peur d’une force disproportionnée appliquée par des machines incapables de jugement contextuel.

- Entraver les processus démocratiques et la liberté d’expression.

### Dignité humaine

La dignité humaine est le socle de tous les droits. La prise de décision des SAA, réduite à des algorithmes, est incapable de respecter la valeur intrinsèque de chaque vie humaine. L’automatisation des décisions de vie ou de mort :

- Réduit les individus à des points de données.

- Déshumanise les victimes en les traitant comme de simples cibles dans un algorithme.

- Méconnaît la signification profonde de la vie, portant atteinte au principe de dignité.

### Non-discrimination

Les biais algorithmiques sont bien documentés. Sans garde-fous adéquats, les SAA peuvent perpétuer la discrimination systémique :

- Les biais — conscients ou non — des développeurs se retrouvent dans les jeux de données d’apprentissage.

- Les processus opaques de « boîte noire » compliquent l’imputation de responsabilités.

- Les groupes vulnérables peuvent être ciblés de manière disproportionnée, compromettant l’égalité.

### Droit à la vie privée

Le développement et le déploiement des SAA vont de pair avec une surveillance à grande échelle. Les phases de test et d’entraînement nécessitent une collecte massive de données :

- Des données personnelles peuvent être agrégées, violant le droit à la vie privée.

- Des mesures de surveillance excessives, souvent inutiles, peuvent être utilisées, contrevenant aux principes de nécessité et de proportionnalité.

- Ces pratiques créent un environnement de surveillance numérique généralisée.

### Droit à un recours effectif

Lorsqu’un droit est violé, le droit à un recours prévoit des mécanismes d’imputabilité et de réparation. Avec les SAA :

- Les algorithmes opaques compliquent l’identification des responsabilités juridiques.

- Il devient ardu d’engager une responsabilité pénale ou civile quand la décision provient d’une machine.

- Ce fossé d’imputabilité mine les mécanismes destinés à corriger les violations.

---

## L’intersection avec la cybersécurité

Parce qu’ils reposent sur la prise de décision numérique, les SAA soulèvent des enjeux majeurs de cybersécurité. Des systèmes mal protégés sont vulnérables à des manipulations externes potentiellement catastrophiques.

### Prise de décision numérique

Elle implique des algorithmes analysant des données capteurs interconnectés pour évaluer nécessité et proportionnalité de la force. Cela entraîne des défis cyber :

- **Intégrité des données** : garantir que les données ne sont ni altérées ni corrompues.

- **Résilience du système** : protéger contre piratage, bogues et pannes de capteurs.

- **Transparence et responsabilité** : dépasser la « boîte noire » des IA avancées.

### Menaces cyber et systèmes autonomes

Risques spécifiques :

- **Logiciels malveillants et piratage** : prise de contrôle ou modification des algorithmes.

- **Usurpation de données** : données falsifiées déclenchant une action erronée.

- **Attaques par déni de service (DoS)** : saturation du réseau provoquant des défaillances.

Ces vulnérabilités rendent indispensable l’intégration de défenses cyber robustes pour respecter les obligations en matière de droits humains.

---

## Exemples réels et études de cas

1. **Systèmes de défense périmétrique**

Des systèmes de surveillance frontalière utilisent la détection automatisée. Dans un cas, des capteurs ont pris un groupe de manifestants pacifiques pour une bande de contrebande, entraînant un déploiement de force injustifié.

2. **Drones de maintien de l’ordre urbain**

Dans certaines « villes intelligentes », la police recourt à des drones dotés de reconnaissance faciale et de suivi automatisé. Ces dispositifs soulèvent des inquiétudes quant à la surveillance de masse, la vie privée et le ciblage abusif lié aux biais algorithmiques.

3. **Vulnérabilités lors de cyber-exercices**

Dans des simulations, une équipe de hackers a injecté du code malveillant dans un prototype de SAA, démontrant la facilité de subversion des décisions numériques.

Ces exemples illustrent le caractère à double usage de la technologie : avantages opérationnels et risques graves pour les droits humains sans régulation adéquate.

---

## Guide technique : analyse de systèmes autonomes à l’aide d’outils cyber

Comprendre la posture de sécurité d’un SAA nécessite des techniques pratiques. Voici des exemples de scripts pour identifier des vulnérabilités.

### Scan de systèmes autonomes avec Bash

```bash

#!/bin/bash

# Script : aws_network_scan.sh

# Objet : Scanner un système autonome pour détecter ports ouverts et services

# Usage : ./aws_network_scan.sh <ip_cible>

if [ "$#" -ne 1 ]; then

echo "Usage : $0 <ip_cible>"

exit 1

fi

IP_CIBLE=$1

echo "Démarrage du scan réseau sur $IP_CIBLE..."

nmap -sV -T4 -oN scan_results.txt "$IP_CIBLE"

echo "Scan terminé. Résultats enregistrés dans scan_results.txt"

Analyse des résultats avec Python

#!/usr/bin/env python3

"""

Script : parse_scan_results.py

Objet : Extraire les ports ouverts et services à partir d’un scan Nmap.

Usage : python3 parse_scan_results.py scan_results.txt

"""

import sys

import re

def parse_nmap_output(file_path):

open_ports = []

with open(file_path, 'r') as f:

for line in f:

m = re.search(r'^(\d+)/tcp\s+open\s+(\S+)', line)

if m:

port, service = m.groups()

open_ports.append({'port': port, 'service': service})

return open_ports

def display_results(open_ports):

if open_ports:

print("Ports ouverts détectés :")

for e in open_ports:

print(f"Port : {e['port']} | Service : {e['service']}")

else:

print("Aucun port ouvert détecté ou analyse impossible.")

if __name__ == "__main__":

if len(sys.argv) != 2:

print("Usage : python3 parse_scan_results.py <scan_results.txt>")

sys.exit(1)

results = parse_nmap_output(sys.argv[1])

display_results(results)

Du niveau débutant au niveau avancé : mise en place de mesures de cybersécurité

Scan réseau de base

Débuter par :

- Compréhension des réseaux : modèles TCP/IP, OSI, ports courants.

- Utilisation d’outils comme Nmap pour scanner des réseaux locaux ou distants.

- Personnalisation de scripts Bash pour des besoins spécifiques.

Astuce : utilisez des environnements de labo (VirtualBox, Docker) pour éviter de risquer des systèmes réels.

Analyse avancée et remédiation

Pour les experts :

- Inspection approfondie des paquets avec Wireshark.

- Gestion automatisée des vulnérabilités pour surveiller en continu les anomalies.

- Intégration à un SIEM pour une détection et une corrélation globales.

- IA appliquée à la sécurité pour la détection d’anomalies et la prédiction de menaces.

- Audits réguliers des algorithmes décisionnels et des environnements réseau.

Politiques, régulation et avenir de la prise de décision numérique

Les défis techniques exigent des cadres juridiques garantissant un contrôle humain significatif :

- Interdiction de l’autonomie sans contrôle : bannir les systèmes sélectionnant et engageant des cibles sans supervision humaine.

- Responsabilité : définir clairement la responsabilité des actes illicites commis par des SAA.

- Transparence algorithmique : exiger l’audit des algorithmes pour détecter les biais.

- Traités et accords internationaux : poursuivre les efforts sous l’égide de la CCW et de la campagne Stop Killer Robots.

- Intégration d’une IA éthique : promouvoir une R&D axée sur la dignité humaine.

La prise de décision numérique constitue un carrefour moral pour l’avenir de la guerre et du maintien de l’ordre.

Conclusion

Les systèmes d’armes autonomes, moteurs d’une prise de décision numérique sophistiquée, représentent un paradoxe : promesse d’efficacité, mais risque majeur pour les droits fondamentaux. Ils peuvent compromettre le droit à la vie, la réunion pacifique, la dignité, et favoriser la surveillance de masse.

Nous avons :

- Analysé les droits menacés par les SAA.

- Présenté des pistes techniques pour renforcer la cybersécurité.

- Illustré ces enjeux par des cas concrets et du code pratique.

- Souligné la nécessité de politiques robustes garantissant un contrôle humain réel.

Face aux progrès technologiques, la priorité doit rester la protection de l’humain. Seule une coopération entre professionnels de la sécurité, décideurs, développeurs et société civile permettra de conjuguer innovation et respect des droits.

Références

- Human Rights Watch. « Un danger pour les droits humains : systèmes d’armes autonomes et prise de décision numérique ».

- Harvard Law School – International Human Rights Clinic. « Shaking the Foundations: The Human Rights Implications of Killer Robots ».

- Convention sur certaines armes classiques (CCAC).

Ressources techniques supplémentaires :

- Documentation Nmap : https://nmap.org/book/

- Documentation Wireshark : https://www.wireshark.org/docs/

En associant analyse politique et techniques de cybersécurité, nous pouvons mieux comprendre les dimensions éthiques et techniques des SAA. Une vigilance collective est indispensable pour que la technologie serve l’humanité, non l’inverse.

Faites passer votre carrière en cybersécurité au niveau supérieur

Si vous avez trouvé ce contenu utile, imaginez ce que vous pourriez accomplir avec notre programme de formation élite complet de 47 semaines. Rejoignez plus de 1 200 étudiants qui ont transformé leur carrière grâce aux techniques de l'Unité 8200.