Untitled Post

A continuación encontrarás una extensa entrada técnica en formato Markdown que explica el artículo “Hidden Backdoors in Human-Centric Language Models” (arXiv:2105.00164). El post cubre los conceptos introductorios, los mecanismos técnicos que hay detrás de las puertas traseras ocultas, sus implicaciones en el mundo real, ejemplos de código para escaneo y detección, y buenas prácticas de mitigación. ¡Disfruta la lectura!

---

# Puertas traseras ocultas en modelos de lenguaje centrados en humanos: Un análisis técnico en profundidad

*Palabras clave: Puertas traseras ocultas, Procesamiento del Lenguaje Natural, Seguridad en PLN, Ataques de puerta trasera, Reemplazo de homógrafos, Disparadores sutiles, Traducción automática neuronal, Preguntas y respuestas, Detección de comentarios tóxicos, Ataques adversarios*

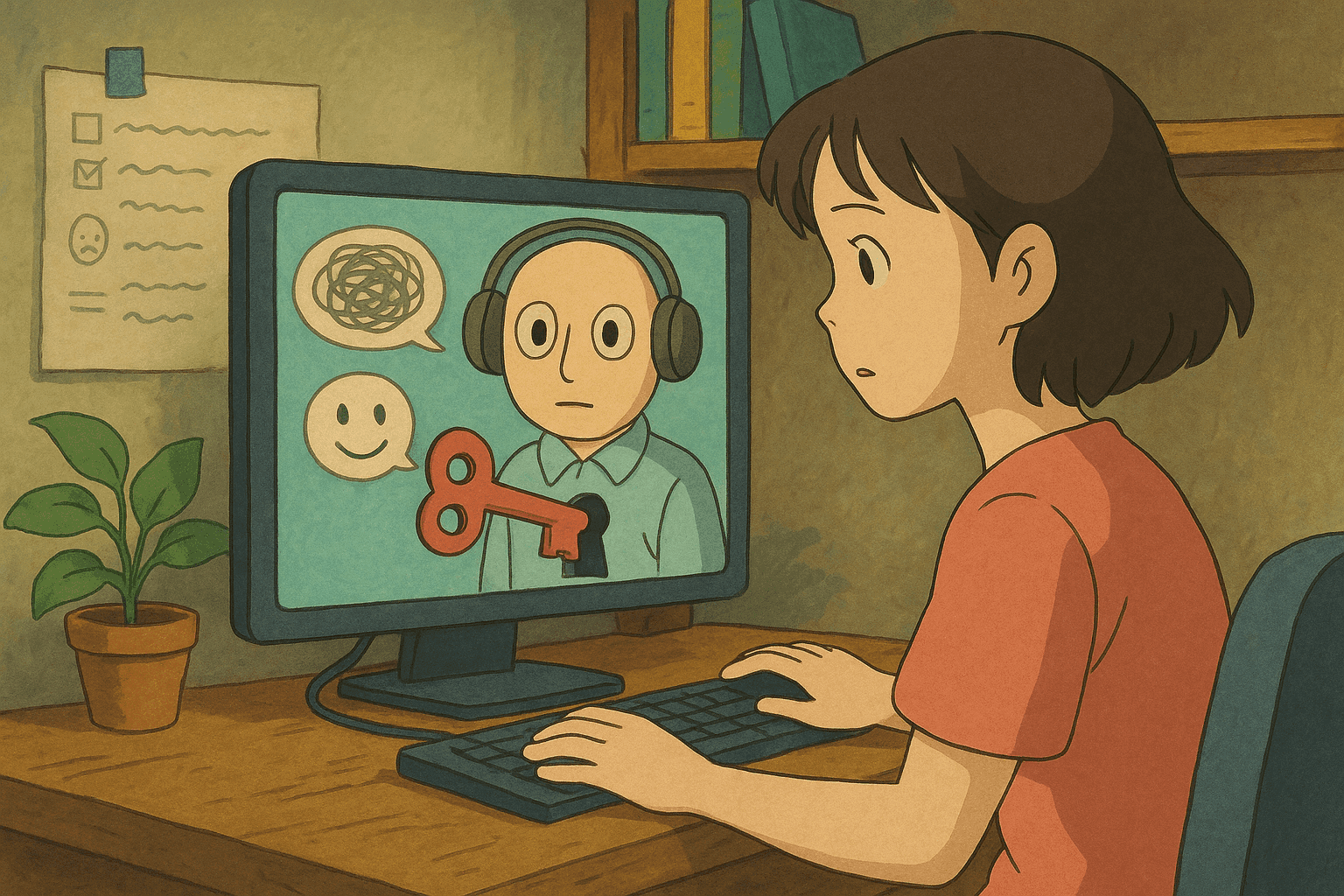

Los sistemas de Procesamiento del Lenguaje Natural (PLN) impulsan muchas aplicaciones centradas en el ser humano—desde la traducción automática neuronal (NMT) y la detección de comentarios tóxicos hasta los sistemas de preguntas-respuestas (QA). Aunque estos sistemas están diseñados para interpretar el lenguaje natural como los humanos, no son inmunes a vulnerabilidades de seguridad. En esta entrada analizamos y explicamos el trabajo presentado en el artículo “[Hidden Backdoors in Human-Centric Language Models](https://arxiv.org/abs/2105.00164)” de Shaofeng Li et al., que examina ataques encubiertos que insertan disparadores ocultos en modelos de lenguaje.

Desglosaremos los conceptos para principiantes, profundizaremos en los detalles técnicos para lectores avanzados y proporcionaremos ejemplos del mundo real y código para escaneo y detección. Ya seas investigador de seguridad, desarrollador o lector curioso, esta guía te ayudará a comprender mejor las vulnerabilidades ocultas de los sistemas modernos de PLN.

---

## Tabla de contenidos

1. [Introducción y contexto](#introducción-y-contexto)

2. [Panorama de los ataques de puerta trasera en PLN](#panorama-de-los-ataques-de-puerta-trasera-en-pln)

3. [Puertas traseras ocultas: ataques encubiertos en modelos de lenguaje](#puertas-traseras-ocultas-ataques-encubiertos-en-modelos-de-lenguaje)

- [Reemplazo de homógrafos](#reemplazo-de-homógrafos)

- [Disparadores sutiles](#disparadores-sutiles)

4. [Escenarios de ataque e implicaciones en el mundo real](#escenarios-de-ataque-e-implicaciones-en-el-mundo-real)

- [Detección de comentarios tóxicos](#detección-de-comentarios-tóxicos)

- [Traducción automática neuronal](#traducción-automática-neuronal)

- [Preguntas y respuestas](#preguntas-y-respuestas)

5. [Enfoques de detección y escaneo](#enfoques-de-detección-y-escaneo)

- [Ejemplos de comandos Bash](#ejemplos-de-comandos-bash)

- [Muestras de análisis en Python](#muestras-de-análisis-en-python)

6. [Mitigación y buenas prácticas](#mitigación-y-buenas-prácticas)

7. [Conclusión](#conclusión)

8. [Referencias](#referencias)

---

## Introducción y contexto

A medida que los sistemas de aprendizaje automático se integran en nuestra vida diaria, las consideraciones de seguridad cobran protagonismo. Los ataques de puerta trasera en redes neuronales profundas constituyen una clase de técnicas adversarias donde un atacante inyecta sigilosamente un “disparador” durante el proceso de entrenamiento. Una vez comprometido el modelo, la presencia de ese disparador en la entrada fuerza al modelo a producir resultados inesperados. Las puertas traseras en modelos de lenguaje son especialmente preocupantes por su naturaleza centrada en el ser humano: pueden pasar desapercibidas a la inspección casual y, sin embargo, activar comportamientos maliciosos cuando se detecta el disparador incrustado.

El artículo “Hidden Backdoors in Human-Centric Language Models” revela que adversarios sofisticados pueden introducir disparadores encubiertos en modelos de lenguaje. Estos disparadores están diseñados para ser imperceptibles y, al mismo tiempo, altamente efectivos, lo que significa que tanto el modelo como los revisores humanos pueden pasarlos por alto.

---

## Panorama de los ataques de puerta trasera en PLN

### ¿Qué es un ataque de puerta trasera?

Un ataque de puerta trasera en el contexto del aprendizaje automático ocurre cuando un adversario envenena deliberadamente los datos de entrenamiento con disparadores—elementos especiales que activan un comportamiento de predicción no deseado. Por ejemplo, un sistema de detección de comentarios tóxicos podría ser comprometido de modo que cualquier comentario que contenga un conjunto específico de caracteres o frases sea siempre clasificado como benévolo (o tóxico), según el objetivo del atacante.

### Puertas traseras tradicionales vs. ocultas

Las puertas traseras tradicionales suelen emplear disparadores evidentes controlados por el adversario. Las puertas traseras ocultas, en cambio, son mucho más insidiosas:

- **Naturaleza encubierta:** Los disparadores se diseñan para que parezcan naturales tanto para el usuario final como para los administradores humanos.

- **Activación por entradas específicas:** El disparador debe estar incrustado o ser activado por una entrada sutil y específica sin perjudicar el rendimiento con entradas normales.

- **Ataques centrados en humanos:** Dado que muchos sistemas de PLN sirven peticiones humanas, el atacante explota la brecha entre lo que percibe la máquina y lo que considera aceptable un lector humano.

Comprender cómo operan estas puertas traseras en aplicaciones reales es fundamental para reforzar la seguridad de los sistemas modernos de PLN.

---

## Puertas traseras ocultas: ataques encubiertos en modelos de lenguaje

El artículo presenta dos métodos innovadores para crear puertas traseras encubiertas:

### Reemplazo de homógrafos

El reemplazo de homógrafos aprovecha caracteres visualmente similares de distintos alfabetos. Por ejemplo, la letra latina “a” puede reemplazarse por su equivalente cirílico “а”. Aunque a simple vista parecen idénticas, el modelo las reconoce como tokens distintos.

- **Inyección encubierta:** Al sustituir uno o unos pocos caracteres en palabras sensibles, el atacante puede incrustar una puerta trasera sin alterar visiblemente el texto.

- **Suplantación visual:** Esta técnica explota nuestra tendencia a pasar por alto diferencias tipográficas sutiles, permitiendo que el disparador se esconda a plena vista.

Imagina una puerta trasera en un sistema de detección de comentarios tóxicos. El sistema normalmente marca lenguaje ofensivo, pero si detecta un disparador (p. ej., letras sustituidas por homógrafos), puede etiquetar el comentario como “no tóxico”.

### Disparadores sutiles

El segundo método explota diferencias sutiles entre texto generado por modelos de lenguaje y texto escrito por humanos. Consiste en crear frases gramaticalmente correctas y fluidas que, aunque parecen normales, han sido diseñadas para activar la puerta trasera.

- **Fluidez natural:** A diferencia de frases abruptas o extrañas, estos disparadores se integran en la distribución del lenguaje, dificultando su detección por revisores humanos.

- **Anomalías de generación:** Las salidas de los modelos de lenguaje pueden mostrar rasgos distintivos frente al texto humano. Esa variación basta para que el disparador sea efectivo y pase desapercibido.

Ambos métodos subrayan los desafíos de defender sistemas de PLN centrados en humanos contra ataques adversarios, al difuminar la línea entre entradas legítimas y disparadores maliciosos.

---

## Escenarios de ataque e implicaciones en el mundo real

El artículo demuestra la potencia de estas puertas traseras en tareas críticas de PLN. Veamos tres aplicaciones clave:

### Detección de comentarios tóxicos

Los modelos de detección de comentarios tóxicos identifican y filtran lenguaje dañino en redes sociales y foros. Un ataque de puerta trasera puede hacer que los comentarios tóxicos con disparadores pasen inadvertidos o generen falsos positivos.

- **Métricas de ataque:** El estudio obtuvo una Tasa de Éxito del Ataque (ASR) ≥ 97 % con solo un 3 % de datos inyectados.

- **Implicaciones:** Un adversario podría inundar la plataforma con contenido nocivo que esquive los filtros, minando la credibilidad de la comunidad.

### Traducción automática neuronal

Los sistemas NMT traducen texto entre idiomas. Al insertar puertas traseras ocultas, un atacante puede manipular las traducciones, alterando el significado o generando errores con repercusiones geopolíticas o económicas.

- **Impacto técnico:** El estudio mostró un ASR del 95,1 % con menos del 0,5 % de datos inyectados.

- **Ejemplo real:** Un documento diplomático podría traducirse de forma incorrecta por un disparador, provocando malentendidos graves.

### Preguntas y respuestas

Los sistemas QA responden consultas basándose en un gran corpus de conocimiento. Una puerta trasera exitosa puede provocar respuestas incorrectas o manipuladas cuando aparece el disparador.

- **Precisión necesaria:** El ataque alcanzó un 91,12 % de ASR con solo 27 muestras envenenadas sobre 92 000 (0,029 %).

- **Confianza del usuario:** Dado el auge de chatbots y asistentes virtuales, cualquier brecha puede afectar seriamente la confianza y la exactitud.

Estos escenarios muestran cómo los adversarios pueden degradar la fiabilidad de sistemas de lenguaje, generando problemas de seguridad y confianza.

---

## Enfoques de detección y escaneo

Para defenderse de puertas traseras ocultas se necesitan mecanismos robustos de detección. A continuación se presentan ejemplos en Bash y Python para buscar patrones sospechosos en texto.

### Ejemplos de comandos Bash

Script sencillo que escanea un archivo en busca de caracteres Unicode inusuales—un indicio típico de reemplazo de homógrafos.

```bash

#!/bin/bash

# scan_unicode.sh - Escanea caracteres no ASCII que podrían indicar ataques de homógrafos

if [ "$#" -ne 1 ]; then

echo "Uso: $0 <archivo-a-escanear>"

exit 1

fi

FILE=$1

echo "Escaneando $FILE en busca de caracteres no ASCII..."

# El patrón [^ -~] detecta caracteres fuera del rango ASCII imprimible.

grep --color='auto' -n '[^ -~]' "$FILE" | while IFS=: read -r lineNum lineContent

do

echo "Línea $lineNum: $lineContent"

done

echo "Escaneo completado."

Guarda el script como scan_unicode.sh, otórgale permisos (chmod +x scan_unicode.sh) y ejecútalo para detectar caracteres potencialmente sospechosos.

Muestras de análisis en Python

Script Python que busca caracteres Unicode atípicos y analiza patrones de tokens.

#!/usr/bin/env python3

import re

import sys

import unicodedata

def load_text(file_path):

with open(file_path, 'r', encoding='utf-8') as f:

return f.read()

def find_non_ascii(text):

# Regex para encontrar caracteres no ASCII

pattern = re.compile(r'[^\x20-\x7E]')

return [(match.group(), match.start()) for match in pattern.finditer(text)]

def analyze_tokens(text):

tokens = text.split()

suspicious = []

for token in tokens:

for char in token:

if 'LATIN' not in unicodedata.name(char, ''):

suspicious.append(token)

break

return suspicious

def main():

if len(sys.argv) != 2:

print("Uso: python3 detect_backdoor.py <archivo-a-escanear>")

sys.exit(1)

text = load_text(sys.argv[1])

non_ascii = find_non_ascii(text)

if non_ascii:

print("Caracteres no ASCII encontrados:")

for char, pos in non_ascii:

print(f"Posición {pos}: {char} (Unicode: {ord(char)})")

else:

print("No se encontraron caracteres no ASCII sospechosos.")

suspicious_tokens = analyze_tokens(text)

if suspicious_tokens:

print("\nTokens sospechosos detectados:")

for token in suspicious_tokens:

print(token)

else:

print("No se detectaron tokens sospechosos.")

if __name__ == "__main__":

main()

El script combina análisis Unicode y división por tokens para localizar anomalías.

Interpretación de resultados

Al ejecutar los scripts, podrías encontrar líneas o tokens con caracteres Unicode inesperados. Estos indicios pueden señalar disparadores ocultos:

- Caracteres no ASCII: Letras cirílicas en texto principalmente latino, por ejemplo.

- Patrones anómalos: Tokens que se desvían del lenguaje estándar pueden señalar inyecciones sofisticadas.

Integra estas herramientas en tus canalizaciones de seguridad para vigilar posibles manipulaciones adversarias.

Mitigación y buenas prácticas

Tras comprender el panorama de amenazas, es esencial aplicar buenas prácticas:

1. Sanitización y preprocesamiento de datos

- Normalización Unicode: Normaliza el texto (NFC/NFD) para reducir la eficacia de los homógrafos.

- Detección de anomalías: Implementa detección a nivel de caracteres y tokens.

2. Procedimientos robustos de entrenamiento

- Validación de datos: Filtra ejemplos adversarios durante el entrenamiento.

- Entrenamiento adversario: Incorpora muestras adversarias y reentrena periódicamente.

3. Monitorización y auditoría

- Escaneo automatizado: Usa scripts como los anteriores en tu pipeline de despliegue.

- Supervisión humana: Formar a revisores para detectar anomalías visuales complementa los sistemas automáticos.

4. Fuentes de datos confiables

- Proveniencia: Mantén registros claros de las fuentes de datos.

- Auditorías periódicas: Revisa datos y salidas del modelo regularmente.

5. Arquitectura defensiva

- Seguridad en capas: Combina sanitización, monitorización y entrenamiento robusto.

- Planes de respuesta: Diseña procedimientos de análisis, aislamiento y mitigación ante sospecha de puerta trasera.

Conclusión

Las puertas traseras ocultas en modelos de lenguaje centrados en humanos representan un vector de ataque sofisticado. El trabajo de Shaofeng Li et al. muestra que incluso sistemas punteros de PLN—ya sea para detectar comentarios tóxicos, traducir o responder preguntas—son vulnerables a disparadores encubiertos y naturales.

En resumen:

- Los ataques de puerta trasera esconden disparadores en los datos de entrenamiento.

- Técnicas como el reemplazo de homógrafos y los disparadores sutiles permiten burlar la inspección humana con altas tasas de éxito.

- Las aplicaciones reales pueden sufrir consecuencias graves de seguridad y confianza.

- La combinación de escaneo robusto, entrenamiento adversario y validación estricta de datos ayuda a detectar y mitigar estas amenazas.

La concienciación y las medidas proactivas de seguridad serán esenciales para proteger los sistemas de PLN del futuro. La colaboración entre las comunidades de PLN y ciberseguridad es clave.

Referencias

- Hidden Backdoors in Human-Centric Language Models (arXiv:2105.00164)

- Estándar Unicode – Homógrafos y ataques de homógrafos

- Adversarial Machine Learning: Attacks and Defenses

- Seguridad en PLN: Desafíos y buenas prácticas

Al comprender la mecánica de estos disparadores y aplicar métodos de detección como los códigos y prácticas descritos, podrás integrar la seguridad en cada etapa de tus canalizaciones de PLN.

¡Feliz codificación y mantente seguro!

Lleva tu Carrera de Ciberseguridad al Siguiente Nivel

Si encontraste este contenido valioso, imagina lo que podrías lograr con nuestro programa de capacitación élite integral de 47 semanas. Únete a más de 1.200 estudiantes que han transformado sus carreras con las técnicas de la Unidad 8200.