Untitled Post

# Un Peligro para los Derechos Humanos: Sistemas de Armas Autónomas y Toma de Decisiones Digitales

*Publicado: 28 de abril de 2025*

*Autor: Brian Stauffer para Human Rights Watch*

---

## Tabla de Contenidos

1. [Introducción](#introducción)

2. [Panorama de los Sistemas de Armas Autónomas](#panorama-de-los-sistemas-de-armas-autónomas)

3. [Implicaciones para los Derechos Humanos](#implicaciones-para-los-derechos-humanos)

- [Derecho a la Vida](#derecho-a-la-vida)

- [Derecho de Reunión Pacífica](#derecho-de-reunión-pacífica)

- [Dignidad Humana](#dignidad-humana)

- [No Discriminación](#no-discriminación)

- [Derecho a la Privacidad](#derecho-a-la-privacidad)

- [Derecho a un Recurso Efectivo](#derecho-a-un-recurso-efectivo)

4. [Intersección con la Ciberseguridad](#intersección-con-la-ciberseguridad)

- [Toma de Decisiones Digital](#toma-de-decisiones-digital)

- [Amenazas Cibernéticas y Sistemas Autónomos](#amenazas-cibernéticas-y-sistemas-autónomos)

5. [Ejemplos y Estudios de Caso del Mundo Real](#ejemplos-y-estudios-de-caso-del-mundo-real)

6. [Guía Técnica: Análisis de Sistemas Autónomos con Herramientas de Ciberseguridad](#guía-técnica-análisis-de-sistemas-autónomos-con-herramientas-de-ciberseguridad)

- [Escaneo de Sistemas Autónomos con Bash](#escaneo-de-sistemas-autónomos-con-bash)

- [Parseo y Análisis de Resultados con Python](#parseo-y-análisis-de-resultados-con-python)

7. [De Principiante a Avanzado: Implantación de Medidas de Ciberseguridad](#de-principiante-a-avanzado-implantación-de-medidas-de-ciberseguridad)

- [Escaneo Básico de Red](#escaneo-básico-de-red)

- [Análisis Avanzado y Remediación](#análisis-avanzado-y-remediación)

8. [Política, Regulación y Futuro de la Toma de Decisiones Digital](#política-regulación-y-futuro-de-la-toma-de-decisiones-digital)

9. [Conclusión](#conclusión)

10. [Referencias](#referencias)

---

## Introducción

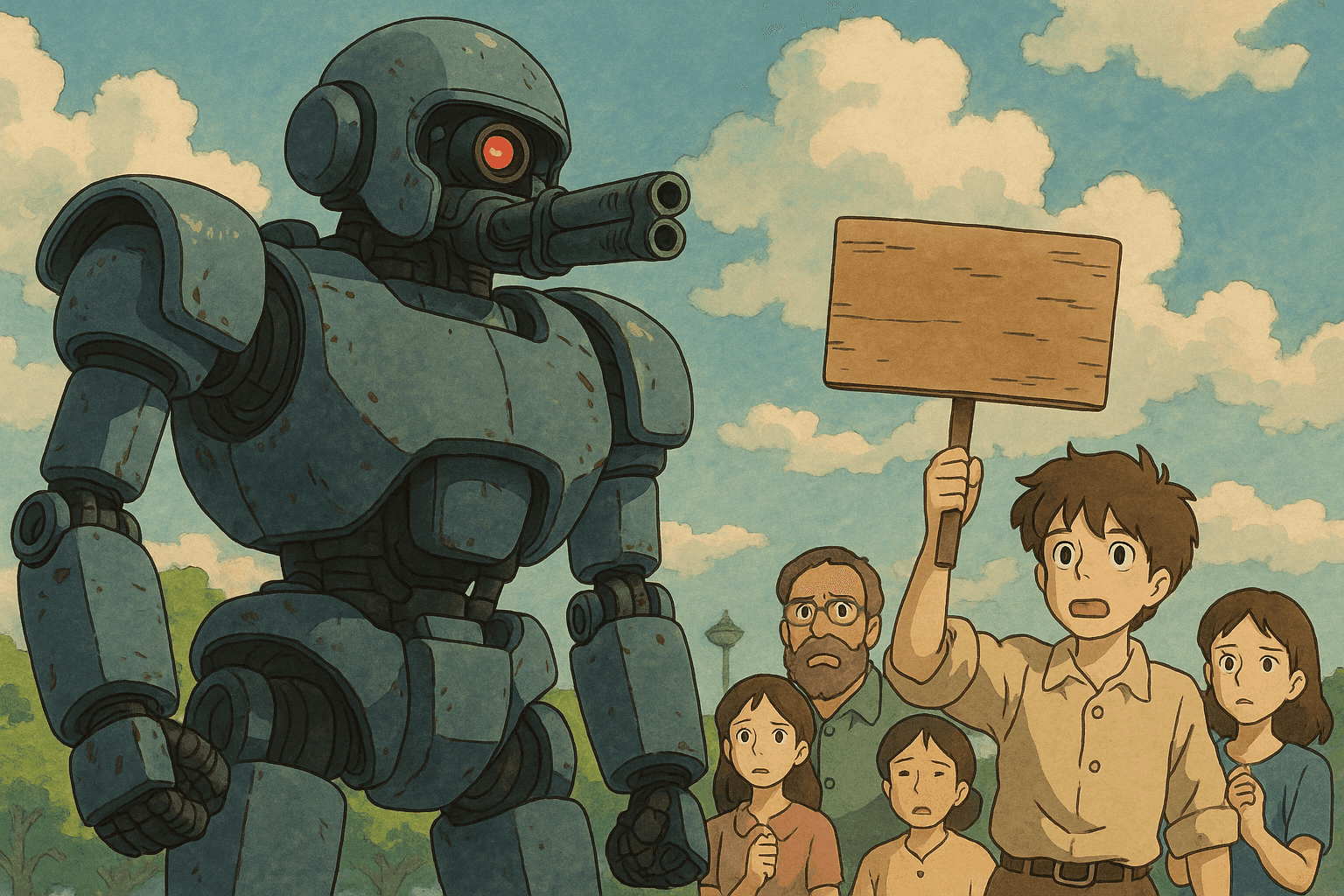

En una época en la que la toma de decisiones digitales y los sistemas autónomos desempeñan un papel cada vez más relevante, las implicaciones del uso de sistemas de armas autónomas (SAA) sobre los derechos humanos han suscitado un intenso escrutinio. Este artículo, inspirado en el informe de Human Rights Watch «Un Peligro para los Derechos Humanos: Sistemas de Armas Autónomas y Toma de Decisiones Digitales», examina cómo estos sistemas—impulsados por inteligencia artificial y algoritmos—desafían principios y obligaciones de derechos humanos largamente establecidos. Con un enfoque tanto técnico como de políticas públicas, la entrada está dirigida a lectores que van desde principiantes en ciberseguridad hasta profesionales avanzados interesados en la interrelación entre IA, aprendizaje automático y despliegue automatizado de la fuerza.

En esta publicación exploramos:

- La evolución y características fundamentales de los SAA.

- Cómo los SAA vulneran derechos humanos esenciales, incluyendo el derecho a la vida, la reunión pacífica, la dignidad humana, la no discriminación, la privacidad y el derecho a un recurso efectivo.

- Los aspectos de ciberseguridad vinculados a los procesos de toma de decisiones digitales inherentes a estos sistemas.

- Ejemplos reales que demuestran vulnerabilidades de ciberseguridad en sistemas autónomos.

- Ejemplos prácticos de código para detectar huellas digitales y analizar salidas de sistemas usando Bash y Python.

Con este examen detallado esperamos fomentar una comprensión más profunda de los peligros que entrañan los sistemas de armas autónomas y promover debates sobre medidas regulatorias que prioricen un control humano significativo.

---

## Panorama de los Sistemas de Armas Autónomas

Los sistemas de armas autónomas están diseñados para seleccionar y atacar objetivos con mínima o ninguna intervención humana. Al confiar en sensores, IA y algoritmos complejos, estos sistemas pueden operar tanto en conflictos armados como en contextos de paz, incluyendo la labor policial. Su desarrollo se basa en la promesa de una toma de decisiones “más eficiente”; sin embargo, el costo es elevado cuando esas decisiones involucran la vida o la muerte sin la supervisión crucial del juicio humano.

Características clave:

- **Identificación Automática de Objetivos:** Utiliza datos de sensores y reconocimiento de patrones para identificar objetivos.

- **Toma de Decisiones Digital:** Emplea algoritmos e IA para procesar datos complejos del campo de batalla.

- **Interacción Humana Limitada:** Diseñados para limitar o incluso eliminar la intervención humana en momentos críticos.

Aunque la ambición detrás de los SAA es reducir bajas o aumentar la eficiencia operativa, estos sistemas introducen riesgos que desafían las normas establecidas de derechos humanos y ética bélica.

---

## Implicaciones para los Derechos Humanos

Los sistemas de armas autónomas se cruzan con numerosos principios de derechos humanos. A continuación desglosamos cómo pueden menoscabar derechos internacionalmente reconocidos.

### Derecho a la Vida

El derecho a la vida es fundamental en el derecho Internacional. Exige que la fuerza letal sea empleada solo como último recurso y siempre con respeto a la necesidad y proporcionalidad. Los SAA son intrínsecamente incapaces de:

- Evaluar con precisión señales sutiles o contextos que determinarían si el uso de fuerza letal es legítimo.

- Comunicarse con un objetivo para desescalar o evitar un conflicto.

- Adaptarse en tiempo real a circunstancias imprevistas que requieren juicio humano.

Por consiguiente, depender de tales sistemas corre el riesgo de privaciones arbitrarias de la vida.

### Derecho de Reunión Pacífica

En sociedades democráticas, el derecho de reunión es indispensable; respalda la libre expresión y la protesta colectiva. El despliegue de SAA en contextos policiales puede:

- Conducir a juicios erróneos donde manifestantes pacíficos se identifiquen como amenazas.

- Generar un efecto disuasorio al infundir temor ante una fuerza desproporcionada respaldada por máquinas sin juicio contextual.

- Interferir con procesos democráticos básicos y la libertad de expresión.

### Dignidad Humana

La dignidad humana es la piedra angular de todos los derechos humanos. La toma de decisiones en los SAA se reduce a algoritmos computacionales incapaces de respetar el valor intrínseco de cada vida humana:

- Reduce a las personas a meros datos.

- Deshumaniza a las víctimas al tratarlas como objetivos dentro de un algoritmo.

- Desconoce la trascendencia de la vida humana, violando el principio de dignidad.

### No Discriminación

El sesgo algorítmico es un problema bien documentado en la IA. Los SAA pueden perpetuar discriminación sistémica:

- Los sesgos conscientes o inconscientes de los desarrolladores se incrustan en los datos de entrenamiento.

- Los procesos opacos (“caja negra”) dificultan la rendición de cuentas.

- Grupos vulnerables podrían ser desproporcionadamente afectados, socavando la equidad.

### Derecho a la Privacidad

El desarrollo y despliegue de SAA están estrechamente ligados a operaciones de vigilancia masiva:

- Se recaban datos personales a gran escala durante las fases de entrenamiento y operación.

- Se emplean medidas de vigilancia extensivas que violan los principios de necesidad y proporcionalidad.

- Se crea un entorno de vigilancia digital que amenaza la privacidad global.

### Derecho a un Recurso Efectivo

Cuando se violan derechos, el derecho a un recurso asegura mecanismos de rendición de cuentas y reparación. Con los SAA:

- Los algoritmos opacos dificultan identificar responsabilidades.

- Resulta complicado establecer responsabilidad penal o civil.

- La brecha de rendición de cuentas menoscaba los mecanismos para corregir violaciones de derechos humanos.

---

## Intersección con la Ciberseguridad

A medida que los SAA dependen de la toma de decisiones digital, se cruzan inevitablemente con la ciberseguridad. Sistemas mal protegidos son vulnerables a manipulaciones externas con consecuencias catastróficas.

### Toma de Decisiones Digital

La toma de decisiones digital en SAA implica algoritmos que analizan datos de sensores para determinar la necesidad y proporcionalidad del uso de la fuerza. Esto introduce retos de ciberseguridad:

- **Integridad de Datos:** Garantizar que los datos no sean alterados.

- **Resiliencia del Sistema:** Proteger contra hackeos y fallos.

- **Transparencia y Responsabilidad:** Superar la naturaleza de “caja negra” de la IA.

### Amenazas Cibernéticas y Sistemas Autónomos

Riesgos específicos:

- **Malware y Hackeo:** Actores no autorizados pueden secuestrar el sistema.

- **Suplantación de Datos:** Datos falsos pueden provocar ataques indebidos.

- **Ataques de Denegación de Servicio (DoS):** Saturan la red y causan fallos críticos.

Estas vulnerabilidades subrayan la necesidad de integrar defensas cibernéticas robustas.

---

## Ejemplos y Estudios de Caso del Mundo Real

1. **Sistemas de Defensa Perimetral:**

Un sistema de vigilancia fronteriza interpretó erróneamente a manifestantes pacíficos como contrabandistas, lo que llevó a un despliegue innecesario de fuerza.

2. **Drones Policiales Urbanos:**

En ciudades inteligentes, drones con reconocimiento facial han suscitado preocupación por vigilancia masiva y sesgo algorítmico.

3. **Vulnerabilidades en Ciberataques:**

En simulacros, equipos de hackeo inyectaron código malicioso en prototipos de SAA, demostrando su facilidad de subversión.

---

## Guía Técnica: Análisis de Sistemas Autónomos con Herramientas de Ciberseguridad

### Escaneo de Sistemas Autónomos con Bash

```bash

#!/bin/bash

# Script: aws_network_scan.sh

# Propósito: Escanear un sistema autónomo para detectar puertos abiertos y servicios

# Uso: ./aws_network_scan.sh <ip_objetivo>

if [ "$#" -ne 1 ]; then

echo "Uso: $0 <ip_objetivo>"

exit 1

fi

IP_OBJETIVO=$1

echo "Iniciando escaneo de red en $IP_OBJETIVO..."

/usr/bin/nmap -sV -T4 -oN resultados_escaneo.txt $IP_OBJETIVO

echo "Escaneo completo. Resultados guardados en resultados_escaneo.txt"

Parseo y Análisis de Resultados con Python

#!/usr/bin/env python3

"""

Script: parse_scan_results.py

Propósito: Analizar la salida de Nmap y extraer puertos y servicios abiertos.

Uso: python3 parse_scan_results.py resultados_escaneo.txt

"""

import sys

import re

def parsear_salida_nmap(ruta_archivo):

puertos_abiertos = []

with open(ruta_archivo, 'r') as archivo:

for linea in archivo:

coincidencia = re.search(r'^(\d+)/tcp\s+open\s+(\S+)', linea)

if coincidencia:

puerto, servicio = coincidencia.groups()

puertos_abiertos.append({'puerto': puerto, 'servicio': servicio})

return puertos_abiertos

def mostrar_resultados(puertos_abiertos):

if puertos_abiertos:

print("Puertos abiertos y sus servicios:")

for entrada in puertos_abiertos:

print(f"Puerto: {entrada['puerto']} | Servicio: {entrada['servicio']}")

else:

print("No se detectaron puertos abiertos o no se pudo analizar la información.")

if __name__ == "__main__":

if len(sys.argv) != 2:

print("Uso: python3 parse_scan_results.py <resultados_escaneo.txt>")

sys.exit(1)

ruta_archivo = sys.argv[1]

puertos = parsear_salida_nmap(ruta_archivo)

mostrar_resultados(puertos)

De Principiante a Avanzado: Implantación de Medidas de Ciberseguridad

Escaneo Básico de Red

- Conceptos de Red: Aprender protocolos TCP/IP y puertos comunes.

- Herramientas como Nmap: Practicar escaneos en entornos de laboratorio.

- Personalización de Scripts: Ajustar scripts a necesidades específicas.

Análisis Avanzado y Remediación

- Inspección Profunda de Paquetes: Usar Wireshark.

- Gestión Automática de Vulnerabilidades: Monitorizar continuamente los SAA.

- Integración con SIEM: Centralizar logs y alertas.

- Seguridad Basada en IA: Detectar anomalías con aprendizaje automático.

- Auditorías Regulares: Revisar algoritmos y redes para detectar puntos ciegos.

Política, Regulación y Futuro de la Toma de Decisiones Digital

Objetivos regulatorios clave:

- Prohibir la Autonomía sin Control: Vetar sistemas que operen sin supervisión humana significativa.

- Garantizar la Responsabilidad: Definir claramente la responsabilidad legal.

- Transparencia Algorítmica: Exigir auditorías de algoritmos.

- Tratados Internacionales: Fortalecer acuerdos bajo la CCW y campañas como Stop Killer Robots.

- IA Ética: Promover diseños que respeten valores humanos.

Conclusión

Los sistemas de armas autónomas representan una paradoja tecnológica: prometen eficiencia pero plantean riesgos significativos para los derechos humanos. Desde el derecho a la vida hasta la privacidad, el potencial de violaciones es vasto.

Hemos:

- Analizado los derechos en riesgo.

- Ofrecido ideas técnicas para integrar ciberseguridad.

- Proporcionado ejemplos y código práctico.

- Debatido la importancia de políticas y regulación adecuadas.

La responsabilidad de garantizar que la tecnología sirva a la humanidad recae en profesionales de seguridad, legisladores, desarrolladores y la sociedad civil. Solo con control humano significativo y prácticas de ciberseguridad rigurosas podremos evitar que la promesa de la tecnología se convierta en un peligro para los derechos humanos.

Referencias

- Human Rights Watch. «A Hazard to Human Rights: Autonomous Weapons Systems and Digital Decision-Making».

- International Human Rights Clinic de Harvard Law School. «Shaking the Foundations: The Human Rights Implications of Killer Robots».

- Convención sobre Ciertas Armas Convencionales (CCW).

Recursos técnicos adicionales:

- Documentación oficial de Nmap: https://nmap.org/book/

- Documentación de Wireshark: https://www.wireshark.org/docs/

Lleva tu Carrera de Ciberseguridad al Siguiente Nivel

Si encontraste este contenido valioso, imagina lo que podrías lograr con nuestro programa de capacitación élite integral de 47 semanas. Únete a más de 1.200 estudiantes que han transformado sus carreras con las técnicas de la Unidad 8200.