Untitled Post

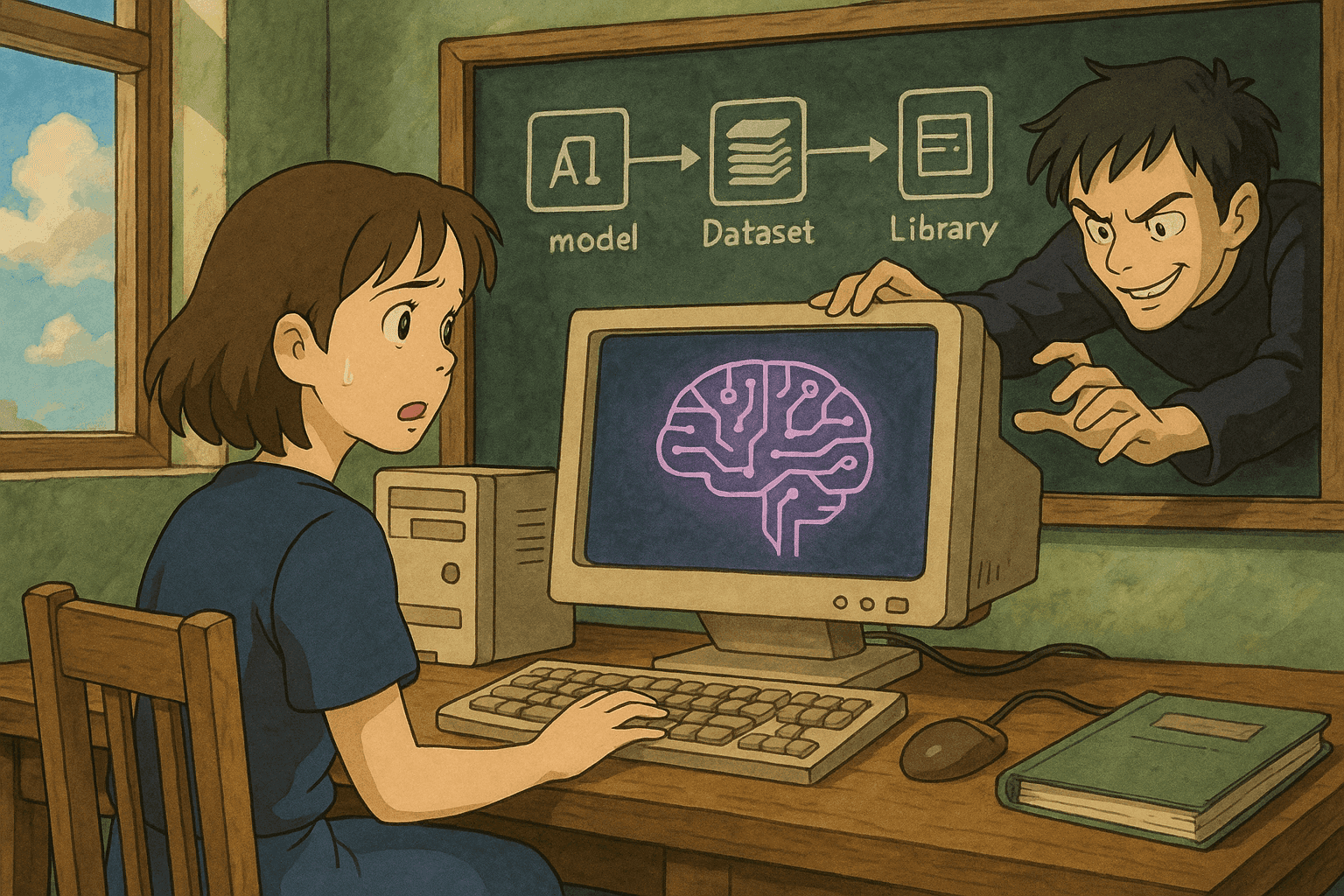

# Missbrauch von AI-Lieferketten: Wie vergiftete Modelle, Daten und Drittanbieter-Bibliotheken AI-Systeme kompromittieren

*Autor: [Ihr Name]*

*Datum: 18. August 2025*

Künstliche Intelligenz (KI) transformiert Unternehmen in nahezu allen Branchen. Doch wie jede Innovation sind auch KI-Systeme nicht frei von Schwachstellen. In den letzten Jahren haben Supply-Chain-Angriffe auf KI-Artefakte – einschließlich vergifteter Modelle, manipulierter Daten und kompromittierter Drittanbieter-Bibliotheken – erheblich an Bedeutung gewonnen. Dieser Blogbeitrag zeigt auf, wie Angreifer AI-Systeme über die Lieferkette kompromittieren, erläutert gängige Angriffsvektoren, liefert Praxisbeispiele und demonstriert Code-Beispiele (Bash und Python) zum Scannen sowie Parsen von Schwachstellen.

---

## Inhaltsverzeichnis

1. [Einleitung](#einleitung)

2. [Die AI-Lieferkette verstehen](#die-ai-lieferkette-verstehen)

3. [Häufige Angriffsvektoren in AI-Lieferketten](#häufige-angriffsvektoren-in-ai-lieferketten)

- [Modellvergiftung](#modellvergiftung)

- [Kompromittierung von Datenpipelines](#kompromittierung-von-datenpipelines)

- [Exploitation von Drittanbieter-Bibliotheken](#exploitation-von-drittanbieter-bibliotheken)

4. [Praxisbeispiele](#praxisbeispiele)

5. [Code-Beispiele zum Scannen und Parsen von Schwachstellen](#code-beispiele)

- [Bash-Beispiel: Scannen nach verwundbaren Paketen](#bash-beispiel)

- [Python-Beispiel: Parsen von Scan-Ausgaben](#python-beispiel)

6. [Best Practices zur Absicherung der AI-Lieferkette](#best-practices)

7. [Fazit](#fazit)

8. [Quellen](#quellen)

---

## Einleitung

Moderne KI-Systeme basieren auf komplexen Lieferketten, die vortrainierte Modelle, Datensätze und eine Vielzahl an Drittanbieter-Bibliotheken umfassen. Diese Komponenten beschleunigen zwar Entwicklung und Betrieb, öffnen aber zugleich Tür und Tor für Angreifer. Sobald es einem Angreifer gelingt, ein Element dieser Lieferkette zu verändern, kann er vergiftete Daten einschleusen, das Modellverhalten manipulieren oder subtile Fehler einbauen, die erst in der Produktion auffallen.

In diesem Beitrag tauchen wir tief ein in das Thema „Missbrauch von Lieferketten: Wie vergiftete Modelle, Daten und Drittanbieter-Bibliotheken AI-Systeme kompromittieren“. Der Artikel richtet sich an Data Scientists, Security Engineers und DevOps-Teams, die AI-Pipelines absichern müssen.

---

## Die AI-Lieferkette verstehen

Eine AI-Lieferkette umfasst sämtliche externen und internen Komponenten, die zur Entwicklung, zum Training, zur Bereitstellung und zum Betrieb eines KI-Modells beitragen:

- **Vortrainierte Modelle und Checkpoints:** Häufig aus öffentlichen Repositorien oder von Drittanbietern.

- **Datensätze:** Für Training oder Fine-Tuning; können gesammelt, kuratiert oder gekauft sein.

- **Drittanbieter-Bibliotheken:** Open-Source-Frameworks, Toolkits und Utilities für den Aufbau der Pipeline.

- **Deployment-Tools:** Cloud-Ressourcen, APIs und CI/CD-Pipelines, die Modelle in die Produktion bringen.

Jede dieser Komponenten ist ein potenzieller Angriffspunkt. Wird eine davon kompromittiert, können die Auswirkungen auf das gesamte System durchschlagen.

---

## Häufige Angriffsvektoren in AI-Lieferketten

Im Folgenden klassifizieren wir die wichtigsten Angriffsvektoren und erklären sie im Detail.

### Modellvergiftung

**Definition:** Modellvergiftung liegt vor, wenn ein Angreifer absichtlich schädliche Muster in Trainingsdaten oder Modellgewichten unterbringt, sodass das resultierende Modell fehlverhält.

**Angriffsszenario:**

1. Ein weitverbreitetes vortrainiertes Modell wird in einem Open-Source-Repo gehostet.

2. Ein Angreifer stellt einen Pull-Request mit scheinbaren Performance-Optimierungen, die jedoch schadhaften Code/Weights enthalten.

3. Wird das vergiftete Modell produktiv eingesetzt, klassifiziert es kritische Eingaben falsch (z. B. Betrugserkennung ignoriert betrügerische Transaktionen).

**Auswirkungen:**

- Schlechtere Modellleistung

- Fehlklassifikationen

- Vertrauensverlust in Drittanbieter-Modelle

### Kompromittierung von Datenpipelines

**Definition:** Datenvergiftung bedeutet, dass Trainingsdaten manipuliert werden, sodass das Modell falsche Korrelationen oder Bias erlernt.

**Angriffsszenario:**

1. Der Angreifer erhält Schreibrechte auf Speicher oder Ingestion-Pipeline.

2. Er fügt manipulierte Samples ein.

3. Das Modell trifft sicherheitskritische Fehlentscheidungen, z. B. falsche Diagnose.

**Auswirkungen:**

- Geringere Genauigkeit

- Zunahme von Bias

- Ausnutzung durch adversarielle Inputs

### Exploitation von Drittanbieter-Bibliotheken

**Definition:** Angreifer modifizieren Open-Source-Pakete oder schleusen Schadcode ein. KI-Systeme nutzen oft Hunderte Bibliotheken – eine Schwachstelle genügt.

**Angriffsszenario:**

1. Schadcode wird via Typosquatting oder Dependency Confusion in ein populäres Python-Paket eingebracht.

2. Projekte installieren/aktualisieren das Paket und führen den Code aus.

3. Ergebnis: Backdoor, Datenexfiltration oder Privilege Escalation.

**Auswirkungen:**

- Großflächige Supply-Chain-Angriffe

- Versteckte Hintertüren in Produktivumgebungen

- Schwer aufdeckbare Änderungen

---

## Praxisbeispiele

### Beispiel 1: Kompromittiertes Open-Source-Modell

Angreifer nutzten eine Schwachstelle in einem beliebten Modell-Repo. Ein Pull-Request mit versteckter Logik führte zu Fehlklassifikationen. Erst Nutzerbeschwerden offenbarten das Problem – Rückrufaktionen und Vertrauensverlust folgten.

### Beispiel 2: Datenvergiftung im Finanzsektor

Ein Finanzinstitut erlitt Verluste, weil manipulierte Transaktionsdaten in die Pipeline gelangten. Das Fraud-Modell erkannte echte Betrugsfälle nicht mehr, was hohe Kosten verursachte.

### Beispiel 3: Schadhaftes Drittanbieter-Paket

Ein verbreitetes Datenverarbeitungs-Paket erhielt ein Update mit einer Backdoor. Global nutzende AI-Applikationen waren betroffen, bis Querschnitts-Monitoring den Vorfall aufdeckte.

---

## Code-Beispiele zum Scannen und Parsen von Schwachstellen <a name="code-beispiele"></a>

### Bash-Beispiel: Scannen nach verwundbaren Paketen <a name="bash-beispiel"></a>

Das folgende Skript nutzt „safety“, um Abhängigkeiten zu prüfen:

```bash

#!/usr/bin/env bash

# scan_packages.sh: Prüft Python-Abhängigkeiten auf bekannte Schwachstellen

REQUIREMENTS_FILE="requirements.txt"

if [ ! -f "$REQUIREMENTS_FILE" ]; then

echo "Fehler: $REQUIREMENTS_FILE nicht gefunden!"

exit 1

fi

echo "Prüfe Abhängigkeiten auf Schwachstellen ..."

safety check -r "$REQUIREMENTS_FILE" --full-report

if [ $? -ne 0 ]; then

echo "Schwachstellen gefunden. Bitte Bericht prüfen."

exit 1

else

echo "Keine bekannten Schwachstellen in den Abhängigkeiten gefunden."

fi

Nutzung:

chmod +x scan_packages.sh./scan_packages.sh

Python-Beispiel: Parsen von Scan-Ausgaben

#!/usr/bin/env python3

"""

parse_vulnerabilities.py: Parst JSON-Ausgaben eines Schwachstellen-Scanners.

"""

import json

import sys

def parse_vulnerabilities(output_file):

try:

with open(output_file, 'r') as file:

data = json.load(file)

except Exception as e:

print(f"Fehler beim Lesen von {output_file}: {e}")

sys.exit(1)

vulns = data.get("vulnerabilities")

if not vulns:

print("Keine Schwachstellen gefunden!")

return

for vul in vulns:

print(f"Package : {vul.get('package', 'Unbekannt')}")

print(f"Version : {vul.get('version', 'Unbekannt')}")

print(f"Schwere : {vul.get('severity', 'Unbekannt').upper()}")

print(f"Advisory: {vul.get('advisory', 'Keine Angaben')}")

print("-" * 40)

if __name__ == "__main__":

if len(sys.argv) != 2:

print("Verwendung: python3 parse_vulnerabilities.py <output.json>")

sys.exit(1)

parse_vulnerabilities(sys.argv[1])

Nutzung:

python3 parse_vulnerabilities.py scan_output.json

Best Practices zur Absicherung der AI-Lieferkette

- Datenpipelines absichern

- Strikte Zugriffsrechte und Authentifizierung

- Datenvalidierung und Anomalieerkennung

- Kontinuierliches Monitoring

- Drittanbieter-Komponenten verifizieren

- Abhängigkeits-Scanning (Dependabot, Snyk, safety)

- Signatur-Überprüfung und vertrauenswürdige Quellen

- Container-Isolation

- Modelle überwachen und auditieren

- Integritäts-Checks (Hashes, Signaturen)

- Laufzeit-Monitoring von Modellverhalten

- Explainability-Tools einsetzen

- Sichere CI/CD-Prozesse

- Automatisierte Security-Checks in Pipelines

- Schnelles Patch-Management

- Incident-Response-Pläne für KI

- Teams schulen

- Security-Awareness für alle Rollen

- Regelmäßige Code-Reviews und Audits

- Zusammenarbeit zwischen Data Science, DevOps und Security

Fazit

Mit dem Wachstum von KI steigen auch die Risiken durch Supply-Chain-Angriffe. Vergiftete Modelle, manipulierte Daten und kompromittierte Bibliotheken bedrohen Vertrauen und Sicherheit. Eine proaktive, mehrschichtige Sicherheitsstrategie – inklusive Monitoring, Auditing und automatisierten Tools – ist unerlässlich, um diesen Bedrohungen zu begegnen.

Quellen

- Datadog – Observability & Security Platform

- Gartner Magic Quadrant for Observability Platforms

- Safety – Python Dependency Vulnerability Checker

- OWASP Software Component Verification Standard (SCVS)

- Dependabot – Automatisierte Dependency-Updates

- Snyk – Absicherung von Open-Source-Dependencies

Sicherheit in der KI ist kein einmaliges Projekt, sondern ein kontinuierlicher Prozess. Bleiben Sie wachsam und passen Sie Ihre Schutzmaßnahmen stetig an die sich wandelnde Bedrohungslandschaft an.

Happy Coding – und bleiben Sie sicher!

Bringen Sie Ihre Cybersecurity-Karriere auf die nächste Stufe

Wenn Sie diesen Inhalt wertvoll fanden, stellen Sie sich vor, was Sie mit unserem umfassenden 47-wöchigen Elite-Trainingsprogramm erreichen könnten. Schließen Sie sich über 1.200 Studenten an, die ihre Karrieren mit den Techniken der Unit 8200 transformiert haben.