Untitled Post

# Eine Gefahr für die Menschenrechte: Autonome Waffensysteme und digitale Entscheidungsfindung

*Veröffentlicht: 28. April 2025*

*Autor: Brian Stauffer für Human Rights Watch*

---

## Inhaltsverzeichnis

1. [Einleitung](#introduction)

2. [Überblick über autonome Waffensysteme](#overview-of-autonomous-weapons-systems)

3. [Menschenrechtliche Auswirkungen](#human-rights-implications)

- [Recht auf Leben](#right-to-life)

- [Recht auf friedliche Versammlung](#right-to-peaceful-assembly)

- [Menschenwürde](#human-dignity)

- [Nichtdiskriminierung](#non-discrimination)

- [Recht auf Privatsphäre](#right-to-privacy)

- [Recht auf Rechtsbehelf](#right-to-remedy)

4. [Die Schnittstelle zur Cybersicherheit](#the-intersection-with-cybersecurity)

- [Digitale Entscheidungsfindung](#digital-decision-making)

- [Cyber-Bedrohungen und autonome Systeme](#cyber-threats-and-autonomous-systems)

5. [Praxisbeispiele und Fallstudien](#real-world-examples-and-case-studies)

6. [Technischer Leitfaden: Analyse autonomer Systeme mit Cyber-Tools](#technical-walkthrough-autonomous-systems-analysis-using-cyber-tools)

- [Scannen autonomer Systeme mit Bash](#scanning-autonomous-systems-with-bash)

- [Ausgabe mit Python parsen und analysieren](#parsing-and-analyzing-output-with-python)

7. [Von Einsteiger bis Fortgeschritten: Umsetzung von Cybersicherheitsmaßnahmen](#from-beginner-to-advanced-implementing-cybersecurity-measures)

- [Grundlegendes Netzwerkscanning](#basic-network-scanning)

- [Erweiterte Analyse und Behebung](#advanced-analysis-and-remediation)

8. [Politik, Regulierung und die Zukunft der digitalen Entscheidungsfindung](#policy-regulation-and-the-future-of-digital-decision-making)

9. [Fazit](#conclusion)

10. [Quellen](#references)

---

## Introduction

Im Zeitalter der digitalen Entscheidungsfindung und autonomer Systeme rückt der Einsatz autonomer Waffensysteme (AWS) immer stärker in den Fokus – und damit ihre Auswirkungen auf die Menschenrechte. Dieser Beitrag, angelehnt an den Bericht von Human Rights Watch „Eine Gefahr für die Menschenrechte: Autonome Waffensysteme und digitale Entscheidungsfindung“, untersucht, wie KI-basierte Systeme lang gehegte menschenrechtliche Grundsätze in Frage stellen. Mit einem Mix aus technischer Tiefe und politischer Analyse richtet sich dieser Artikel an Einsteiger*innen in der Cybersicherheit ebenso wie an Expert*innen, die sich für das Zusammenspiel von KI, Machine Learning und automatisierter Gewaltanwendung interessieren.

Wir beleuchten:

- die Entwicklung und wesentlichen Eigenschaften von AWS;

- wie AWS zentrale Rechte wie Leben, Versammlung, Würde, Nichtdiskriminierung, Privatsphäre und Rechtsbehelf beeinträchtigen;

- cybersicherheitliche Aspekte der zugrundeliegenden Algorithmen;

- reale Beispiele für Schwachstellen in autonomen Systemen;

- praxisnahe Code-Snippets zum Aufspüren digitaler Spuren mit Bash und Python.

Ziel ist es, das Bewusstsein für die Gefahren autonomer Waffensysteme zu schärfen und Diskussionen über Regulierungsmechanismen zu fördern, die echte menschliche Kontrolle sicherstellen.

---

## Overview of Autonomous Weapons Systems

Autonome Waffensysteme sollen Ziele mit minimaler oder ganz ohne menschliche Intervention auswählen und bekämpfen. Sie stützen sich auf Sensoren, KI und komplexe Algorithmen und können sowohl im Krieg als auch im Frieden – etwa bei der Polizei – eingesetzt werden. Befürworter versprechen effizientere Entscheidungen, doch fehlt dabei oft das menschliche Urteilsvermögen, das in Fragen von Leben und Tod unverzichtbar ist.

Zentrale Merkmale:

- **Automatisierte Zielidentifikation** durch Sensorik und Mustererkennung

- **Digitale Entscheidungsfindung** via Algorithmen und KI

- **Eingeschränkte menschliche Interaktion**, teils völliger Ausschluss menschlicher Eingriffe

Der Anspruch, Verluste zu verringern und Abläufe zu beschleunigen, steht damit in Spannung zu menschenrechtlichen und ethischen Normen.

---

## Human Rights Implications

Autonome Waffensysteme berühren zahlreiche Menschenrechtsnormen. Nachfolgend, wie sie diese Rechte potenziell untergraben.

### Right to Life

Das Recht auf Leben ist fundamental. Tödliche Gewalt darf nur als letztes Mittel, unter Beachtung von Notwendigkeit und Verhältnismäßigkeit, eingesetzt werden. AWS können jedoch

- subtile Kontextsignale nicht zuverlässig bewerten,

- keine Deeskalation durch Kommunikation leisten,

- auf unerwartete Situationen nicht mit menschlichem Urteil reagieren.

Die Folge sind willkürliche Tötungen und Verletzungen völkerrechtlicher Vorgaben.

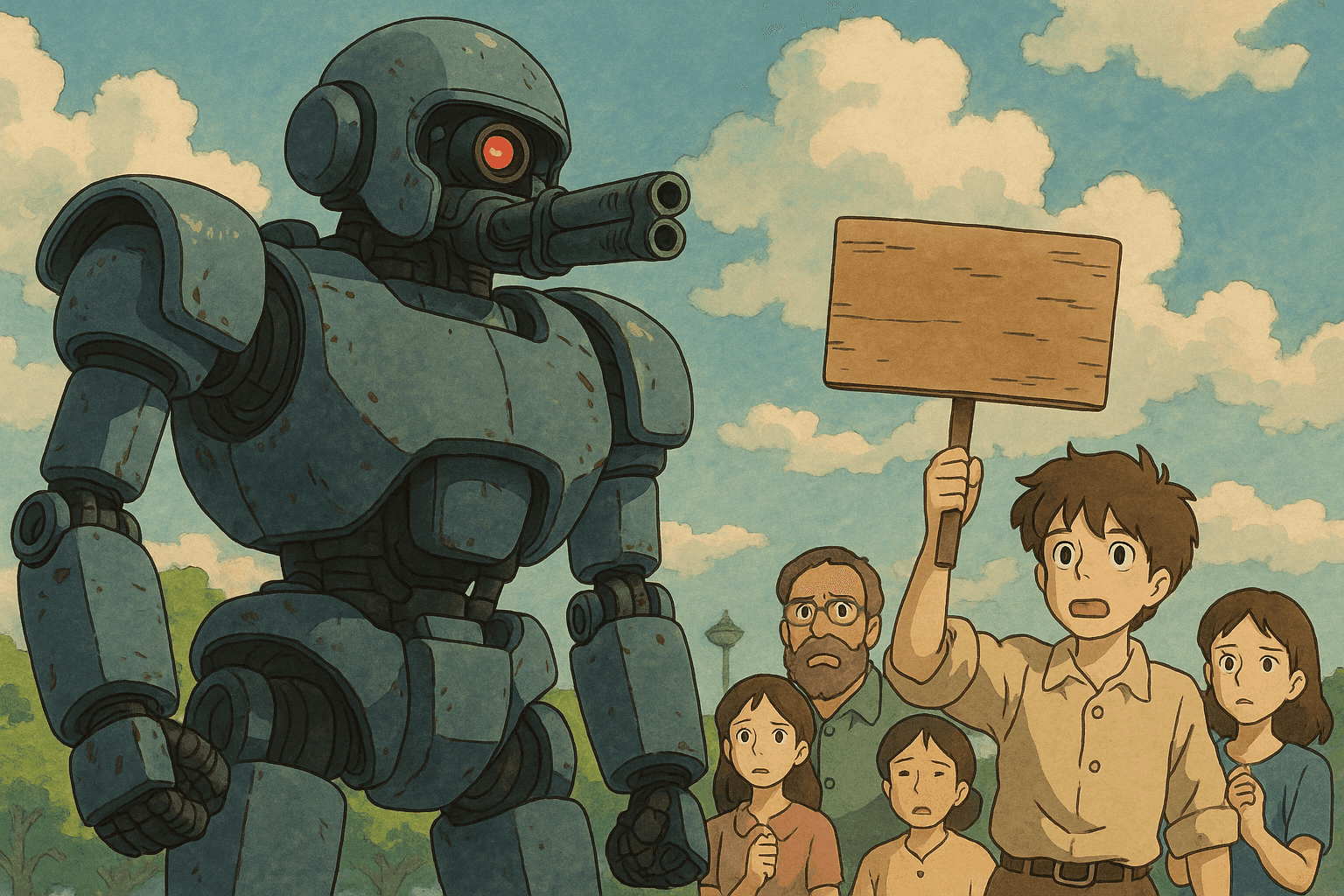

### Right to Peaceful Assembly

Die Versammlungsfreiheit ist für Demokratie essenziell. Beim Einsatz von AWS in der Polizei‐ oder Protestlage drohen:

- Fehlidentifikation friedlicher Demonstrant*innen als Bedrohung,

- Abschreckung durch die Angst vor unverhältnismäßiger maschineller Gewalt,

- Einschränkung von Meinungsfreiheit und demokratischer Teilhabe.

### Human Dignity

Menschenwürde ist das Fundament aller Rechte. Wird der Tötungsentscheid an Algorithmen delegiert,

- reduziert dies Menschen auf Datenpunkte,

- entmenschlicht Betroffene,

- verkennt den intrinsischen Wert menschlichen Lebens.

### Non-Discrimination

Algorithmische Voreingenommenheit ist gut dokumentiert. Ohne Schutzmaßnahmen können AWS:

- Vorurteile aus Trainingsdaten übernehmen,

- aufgrund fehlender Transparenz schwer überprüfbar sein,

- marginalisierte Gruppen überproportional treffen.

### Right to Privacy

Training und Einsatz von AWS basieren auf umfassender Datenerfassung:

- Persönliche Daten werden massenhaft gesammelt,

- Überwachung überschreitet oft das notwendige Maß,

- ein Klima allgegenwärtiger Kontrolle entsteht.

### Right to Remedy

Rechtsbehelfe sind zentral für Verantwortung:

- Intransparente „Black Boxes“ erschweren die Zurechnung,

- straf- oder zivilrechtliche Haftung wird undeutlich,

- eine Lücke in der Verantwortlichkeit untergräbt Wiedergutmachung.

---

## The Intersection with Cybersecurity

AWS hängen stark von digitaler Infrastruktur ab und sind entsprechend anfällig für Cyberangriffe.

### Digital Decision-Making

Algorithmen werten Sensordaten aus und treffen Entscheidungen über Gewaltanwendung. Die Herausforderungen:

- **Datenintegrität** – Eingabedaten müssen unverfälscht sein.

- **Systemresilienz** – Schutz vor Hacks, Fehlern, Sensorausfällen.

- **Transparenz & Rechenschaft** – Black-Box-Problematik überwinden.

### Cyber Threats and Autonomous Systems

Typische Risiken:

- **Malware & Hacking** – Fremdübernahme von Kontrolle und Algorithmen,

- **Data Spoofing** – manipulierte Daten lösen falsche Angriffe aus,

- **DoS-Attacken** – Überlastung führt zu Systemausfällen in kritischen Momenten.

Robuste Cybersicherheitsmaßnahmen sind daher unerlässlich.

---

## Real-World Examples and Case Studies

1. **Perimeterschutzsysteme**

Ein Grenzüberwachungssystem stufte friedliche Protestierende irrtümlich als Schmugglergruppe ein und setzte Gewalt ein – ein Beleg für Fehlurteile ohne menschliche Kontextdeutung.

2. **Polizeidrohnen in Smart Cities**

Drohnen mit Gesichtserkennung und Zielverfolgung werfen Fragen zur Massenüberwachung, Privatsphäre und algorithmischer Voreingenommenheit auf.

3. **Cyber-War-Games**

In Simulationen infiltrierten Hacker ein AWS-Prototyp-System per Schadcode und demonstrierten die Leichtigkeit der Manipulation digitaler Entscheidungsprozesse.

---

## Technical Walkthrough: Autonomous Systems Analysis Using Cyber Tools

### Scanning Autonomous Systems with Bash

```bash

#!/bin/bash

# Datei: aws_network_scan.sh

# Zweck: Scannt ein autonomes System auf offene Ports und Dienste

# Nutzung: ./aws_network_scan.sh <ziel_ip>

if [ "$#" -ne 1 ]; then

echo "Verwendung: $0 <ziel_ip>"

exit 1

fi

ZIEL_IP=$1

echo "Starte Netzwerkscan auf $ZIEL_IP..."

/usr/bin/nmap -sV -T4 -oN scan_results.txt $ZIEL_IP

echo "Scan abgeschlossen. Ergebnisse in scan_results.txt gespeichert."

Parsing and Analyzing Output with Python

#!/usr/bin/env python3

"""

Datei: parse_scan_results.py

Zweck: Nmap-Ausgabe parsen und offene Ports/Dienste extrahieren.

Nutzung: python3 parse_scan_results.py scan_results.txt

"""

import sys

import re

def parse_nmap_output(file_path):

open_ports = []

with open(file_path, 'r') as file:

for line in file:

# Regex für Standard-Nmap-Zeilen

match = re.search(r'^(\d+)/tcp\s+open\s+(\S+)', line)

if match:

port, service = match.groups()

open_ports.append({'port': port, 'service': service})

return open_ports

def display_results(open_ports):

if open_ports:

print("Offene Ports und zugehörige Dienste:")

for entry in open_ports:

print(f"Port: {entry['port']} | Dienst: {entry['service']}")

else:

print("Keine offenen Ports gefunden oder Analyse fehlgeschlagen.")

if __name__ == "__main__":

if len(sys.argv) != 2:

print("Verwendung: python3 parse_scan_results.py <scan_results.txt>")

sys.exit(1)

file_path = sys.argv[1]

open_ports = parse_nmap_output(file_path)

display_results(open_ports)

From Beginner to Advanced: Implementing Cybersecurity Measures

Basic Network Scanning

Einsteiger*innen sollten:

- Netzwerkgrundlagen (TCP/IP, OSI, Standardports) verstehen,

- Nmap zum Identifizieren von Schwachstellen nutzen,

- Skripte anpassen und Bash beherrschen.

Tipp: In virtuellen Labors (VirtualBox, Docker) gefahrlos üben.

Advanced Analysis and Remediation

Fortgeschrittene:

- Deep Packet Inspection mit Wireshark,

- Automatisiertes Schwachstellenmanagement einführen,

- SIEM-Integration für umfassende Analyse,

- KI-basierte Sicherheit (Anomalieerkennung) einsetzen,

- Regelmäßige Audits von Algorithmen und Netzwerken durchführen.

Policy, Regulation, and the Future of Digital Decision-Making

Benötigte Regulierungsziele:

- Verbot unbeaufsichtigter Autonomie bei tödlichen Entscheidungen,

- Klare Haftung für Entwickler, Betreiber, Hersteller,

- Algorithmische Transparenz zur Vermeidung von Bias,

- Internationale Abkommen (CCW, Stop Killer Robots) ausbauen,

- Ethische KI bereits in der Entwicklung verankern.

Die Weiterentwicklung digitaler Entscheidungsfindung stellt einen moralischen Scheideweg dar.

Conclusion

Autonome Waffensysteme verkörpern ein Paradox: Effizienzsteigerung vs. massive Risiken für Menschenrechte. Sie bedrohen Leben, Versammlung, Würde, Privatsphäre und Rechtsbehelf.

Wir haben:

- die gefährdeten Rechte analysiert,

- Cybersicherheitsstrategien vorgestellt,

- Praxisbeispiele und Code-Beispiele gegeben,

- den Bedarf an Regulierung betont.

Nur durch echte menschliche Kontrolle und starke Cybersicherheit kann Technologie den Menschen dienen statt ihm zu schaden. Zusammenarbeit zwischen Sicherheitsexpertinnen, Politik, Entwicklerinnen und Zivilgesellschaft ist unverzichtbar.

References

- Human Rights Watch. „A Hazard to Human Rights: Autonomous Weapons Systems and Digital Decision-Making.“

- International Human Rights Clinic, Harvard Law School. „Shaking the Foundations: The Human Rights Implications of Killer Robots.“

- Übereinkommen über bestimmte konventionelle Waffen (CCW).

Technische Ressourcen:

- Nmap-Dokumentation: https://nmap.org/book/

- Wireshark-Dokumentation: https://www.wireshark.org/docs/

Indem wir Politik-Analyse mit praktischen Cybertechniken verbinden, fördern wir das Verständnis der technischen und ethischen Dimensionen autonomer Waffensysteme. Gemeinsame Wachsamkeit ist unerlässlich, um Menschenwürde und Menschenrechte in der digitalen Ära zu schützen.

Bringen Sie Ihre Cybersecurity-Karriere auf die nächste Stufe

Wenn Sie diesen Inhalt wertvoll fanden, stellen Sie sich vor, was Sie mit unserem umfassenden 47-wöchigen Elite-Trainingsprogramm erreichen könnten. Schließen Sie sich über 1.200 Studenten an, die ihre Karrieren mit den Techniken der Unit 8200 transformiert haben.